목차

Abstract

50년 동안 nonstationarity, poor predictive bahaviour, weak historical coupling과 같은 금융 시장의 행동 방식을 모델링하는 것에 대해 과학계에서는 관심을 끌었고, 지속적인 노력을 하고 있다.

전통적으로 신호 처리(signal processing) 및 제어 이론(Contro Theory)의 맥락에서 dynamic system의 수학적 공식은 금융 엔지니어링의 핵심이였다.

보다 최근에는 강화 학습 개념을 통해 순차적 의사결정의 진보는 순차적 포트폴리오 최적화 전략의 핵심 요소인 다단계 확률적 최적화(multistage stochastic optimization)의 개발에 있어 중요한 역할을 해왔다.

본 논문에서는 전통적인 시스템 인식(모델 기반 접근법) 뿐만 아니라 context와는 독립적인 (model free) 모두를 기반으로 trading agent(Deep Soft Recurrent Q-Network)의 expressive power, modeling efficiency, and performance advantages에 대한 포괄적인 설명을 한다고 한다.

이 분석은 계산이나 메모리 복잡성을 감소할 뿐만 아니라, 자산 및 시장 전반에 걸친 전략의 일반화 역할을 할 수 있는 범용 trading agent 역할을 하는 model free rl의 능력에 대한 결정적인 자료를 제공한다.

금융 시장 데이터의 비교적 낮은 일일 수익률은 데이터 확대(생성적 접근법)와 사전 학습 전략 선택을 통해 해결되며, 두 가지 모두 최신 모델에 대해 검증된다.

엄격성을 위해서, 거래 비용을 포홈하는 risk-sensitive framework를 고려하고, 성능 이점은 다양한 시나리오에의해 설명한다.

synthetic time-series (sinusoidal, sawtooth and chirp waves), simulated market series (surrogate data based), through to real market data (S&P 500 and EURO STOXX 50).

분석 및 시뮬레이션을 통해 자산 할당 전략에서 universal model free rl agent는 연간 누적 수익률 9.2% 연간 sharp ratio에서 13.4% 성과를 달성했다고 한다.

Conclusion (104~105)

이 보고서의 주요 목표는 순차 포트폴리오 관리에 대한 강화 학습 agent의 효과를 조사하는 것이었다. 이를 위해 신호 처리, 제어 이론, 시스템 인텔리전스 및 재무 분야의 많은 개념들이 탐색, 확장 및 결합되었습니다.

이 챕터에서는 향후 연구를 위한 가능한 축과 함께 프로젝트의 기여와 성과를 요약합니다.

Contributions

- episodic 강화학습을 하기 위해서는, 이산 시간 확률적 동적 시스템으로써 금융 시장의 수학적 공식을 제공되어, training agent와 투자 전략을 위한 다재다능한 통합 프레임워크를 제시했다. 시스템 식별(즉, model based)뿐 아니라 context agnostic 에이전트(즉, model free)를 포함하는 강화제들에 대한 포괄적인 설명이 개발되었다.

- model free 범용 강화 학습 에이전트 제품군이 도입되어 모델 계산 및 메모리 복잡성을 줄이고(즉, 우주 크기에 따른 선형 확장), 학습 환경에 관계없이 자산 및 시장 전반의 전략을 일반화할 수 있었습니다. 또한, 공개 문헌에 나와 있는 모든 거래 대리점보다 높은 S&P 500 및 EURO STOXX 50 시장의 실적을 기록했습니다.

- 모델 사전 학습, 데이터 확대 및 시뮬레이션은 사용 가능한 실제 시장 데이터의 수가 제한된 경우에도 심층 신경 네트워크 아키텍처의 강력한 교육을 가능하게 했다.

Future Work

- 성능에도 불구하고, 해석 능력의 결여와 철저한 테스트 부족은 실무자들이 이 솔루션 선택하는 것을 단념하게 했다고 함.

- 해석 능력 중요!

- black box를 열고, 그 결정에 대해 추론할 수 있게 하여(XAI) 학습된 전략을 조사하고 해석을 해야 한다고 함.

- 또한, 금융 시장의 프레임워크 형성에 의해 주어진 많은 자유도를 활용하여 보상 생성 기능과 국가 대표성에 대한 추가 연구를 통해 대리인의 융합 특성과 전반적인 성과를 개선할 수 있다.

- 유효한 접근법은 금융상품의 기술적 분석에 일반적으로 사용되는 지표를 구성하는 것이다(King and Levine, 1992). 이러한 조치들은 수십 년 간의 활동 동안 재무 분석가들이 습득한 전문 지식을 포함하고 대리인을 더 나은 의사결정을 하도록 안내하는 데 도움이 될 수 있다(Wilmott, 2007).

- 베이지안 추론이나 다른 불확실성을 추정할 수 있는 방법을 사용하여, 확률적으로 환경을 모델링 하면 좋음

- Fourier domain 적용하여, 추정 편차를 제거 및 학습 가속 가능

result & discussion

- 어떤 종류의 데이터 사용하였는 지?

- 어떤 분석 방법을 사용하여, 논리를 뒷밤침하고 있는지

- data

- Synthetic Data

- Deterministic process

- Simulated Data

- Market Data

- Standard & Poor's 500

- EURO STOXX 50

- Synthetic Data

- Deterministic series, including sine, sawtooth and chirp waves, as in Section 8.1;

- Simulated series, using data surrogate methods, such as AAFT, as in Section 8.2.

Deterministic Processes

Sinusoidal Waves

Sawtooth Waves

Chirp Waves

전반적으로 deterministic financial market에서 모든 거래대행자들은 수익성 있는 전략을 배우고 자산배분 과제를 해결한다. 예상대로, 모델 기반 에이전트, 특히 RNN은 정상 동작, 모델링 용이성 및 결정론적 시리즈(예: 사인파, 톱니)에서 상당히 우수한 성능을 발휘하고 있습니다. 반면, 보다 복잡한 설정(예: chirp wave universe)에서는 모델 프리 에이전트가 모델 기반 에이전트와 거의 비슷한 성능을 발휘합니다.

Simulated Data

확률적 프로세스 제품군 및 그에 해당하는 매개 변수를 무작위로 선택하는 대신, 실제 시장 데이터를 사용하여 데이터를 설명하는 후보 생성 프로세스의 매개 변수를 학습한다. 이 접근법의 목적은 두 가지입니다.

- There is no need for hyperparameter tuning;

- The training dataset is expanded, via data augmentation, giving the opportunity to the agents to gain more experience and further explore the joint state-action space.

데이터 증강은 특히 Transfer Learning을 통해 시뮬레이션 환경에서 학습한 전략이 실제 시장 데이터에 전송되고 다듬어질 때 전반적인 성능을 향상시킨다는 점을 강조할 필요가 있습니다.

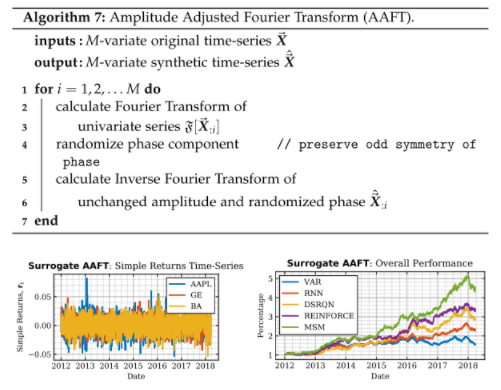

Amplitude Adjusted Fourier Transform (AAFT) (106pg)

위에서 보면, 간단하게 이해한 것으로는 데이트 증강 방식의 하나로써, 기존의 trend 같은 것들은 유지하는 상태에서 노이즈를 조금 더 주는 정도로 이해됨.

AAFT라는 방법론을 통해서, 가상의 데이터를 생성(amplitude spectrum은 보존)

(복잡... 이쪽 계통에서는 많이 쓰는 방법론으로 생각됨)

RL이 더 이러한 확률적 공간에서 더 잘 작동한다는 것을 말하고 싶은 것 같음.

- ToDo

- Portfolio Management 에 대한 이해

- 강화학습 구성 방법

- 강화학습 적용 및 검증 방법

- 실제 현실을 반영하기 위해서 한 노력들

참고

| paper | url |

| 논문 | https://arxiv.org/pdf/1909.09571.pdf |

'관심있는 주제 > RL' 카테고리의 다른 글

| RL) 로봇 개발 플랫폼 Issac 자료 찾아보기 (0) | 2021.09.05 |

|---|---|

| Paper) Reinforcement Learning for Solving the Vehicle Routing Problem (0) | 2021.08.21 |

| Paper) Multi-Agent Game Abstraction via Graph Attention Neural Network (0) | 2021.07.03 |

| Paper) PettingZoo (MARL Environment) 논문 읽어보기 (0) | 2021.06.19 |

| Paper) Decision Transformer: Reinforcement Learning via Sequence Modeling (0) | 2021.06.08 |