트랜스포머에 강화학습 적용하는 것 관련 논문인 듯

확인할 리스트에 추가

Abstract

시퀀스 모델링 문제로 강화 학습(RL)을 추상화하는 프레임워크를 소개.

트랜스포머 아키텍처의 단순성과 확장성, 그리고 GPT-x 및 BERT와 같은 언어 모델링의 관련 발전을 이용 가능.

특히, 우리는 RL의 문제를 조건부 시퀀스 모델링으로 캐스팅하는 아키텍처인 decision transformer를 제시

value function을 fit 또는 policy gradient를 계산하는 RL에 대한 이전 접근법과 달리, decision transformer는 인과적으로 마스크된 transforemr를 활용하여 최적의 동작을 출력 가능

원하는 수익(보상), 과거 상태 및 조치에 대한 자기 회귀 모델(autoregressive model)을 조건화함으로써, 우리의 의사 결정 변환기 모델은 원하는 수익을 달성하는 미래 행동을 생성할 수 있다.

단순함에도 불구하고 decision trasformer는 n Atari, OpenAI Gym, and Key-to-Door tasks에서 최신 모델이 없는 offline RL 기준선과 일치하거나 그 성능을 초과한다고 한다.

1. Introduction

저자는 transformer를 강화 학습(RL)으로 공식화된 순차적 의사 결정 문제에 대한 응용을 검토하려고 한다.

기존 RL 알고리즘 내의 구성 요소에 대한 아키텍처 선택으로 trasnformer를 사용한 이전 작업과 달리, generative trajectory modeling(즉, 상태, 동작 및 보상의 결합 분포를 모델링)이 기존 RL 알고리즘의 대체물로 작용할 수 있는지 연구하려고 한다.

기존의 temporal difference(TD) Learning을 통해서 학습하는 방법 대신에, sequence modeling objective를 사용하여 축적된 experience로 transformer 모델을 훈련할 것이다.

이런 방법을 통해서 long term credit assignment를 위한 boostraping 필요성을 우회할 수 있다고 주장한다.

이것을 통해서 RL을 불안정하게 하는 deadly triad라는 문제를 피할 수 있게 된다고 한다.

또한 TD 학습에서 전형적으로 수행하는 것처럼, 바람직하지 않은 근시안적 행동을 유도할 수 있는 미래 보상을 할인할 필요가 없다고 합니다.

또한, 우리는 확장하기 쉬운 언어와 비전에 널리 사용되는 기존 transformer 프레임워크를 활용하여 변압기 모델의 안정적인 훈련을 연구할 수 있다. (stability)

long sequence를 모델링하는 입증된 능력 외에도 transformer의 또 다른 장점은 self attention에 의하여 credit assignment를 수행할 수 있게 됩니다. 반대로 bellman 백업에서는 보상을 서서히 전파하고 방해 신호를 발생시키기 쉽습니다. 이러한 점은 transformer가 sparse 하거나 distracting 한 reward의 존재에 대해서도 잘 작동할 수 있게 합니다.

마지막으로, 경험적 증거는 transformer 모델링 접근법이 광범위한 distribution of behaviors를 모델링하여 더 나은 일반화와 transfer을 가능하게 할 수 있음을 시사한다고 주장합니다.

저자는 offline RL을 고려하여 가설을 탐구하는데, 여기서 저자는 차선의 데이터에서 학습 정책을 에이전트에게 부과하여 고정적이고 제한된 경험에서 최대 효과적 행동을 생성한다.

이 작업은 전통적으로 오류 전파와 가치 과대평가로 인해 어렵다고 하며 시퀀스 모델링 목표를 가지고 훈련할 때는 자연스러운 작업이라 주장한다.

상태, 동작 및 반환 시퀀스에 대해 자동 회귀 모델을 훈련함으로써 정책 샘플링을 자동 회귀 생성 모델링으로 축소한다. 원하는 반환 토큰을 선택하여 생성 프롬프트 역할을 함으로써 정책의 전문성(질문할 스킬)을 지정할 수 있습니다.

저자의 제안에 대한 직관을 얻기 위해, RL 문제로 제기될 수 있는 지시된 그래프에서 가장 짧은 경로를 찾는 작업을 고려한다. 에이전트가 목표 노드에 있을 경우 보상은 0이고, 그렇지 않을 경우 -1입니다. 우리는 GPT [9] 모델을 교육하여 진행 중인 보상(미래 보상 합계), 상태 및 조치의 순서로 다음 토큰을 예측한다. 전문가 시연 없이 무작위 보행 데이터에 대해서만 훈련하면 가능한 최고 수익(부록의 자세한 내용 및 경험적 결과 참조)을 생성하기 전에 추가함으로써 테스트 시간에 최적의 궤적을 생성하고 이후 조건화를 통해 해당 action 순서를 생성할 수 있다. 따라서 시퀀스 모델링의 도구를 후 시점 반환 정보와 결합함으로써 동적 프로그래밍 없이도 정책 개선을 달성한다.

저자는 직관적으로 설명을 다음과 같이 하였다. directed graph에서 짧은 경로 찾기 문제를 강화학습으로 한다고 하였을 때, 에이전트는 골에 도착하면 0, 그렇지 않으면 -1로 준다.

GPT 모델을 훈련시켜서 returns-to-go, state , action을 sequence로 다음 토큰을 예측한다.

해당 학습은 전문가의 시연없이 random walk data로 훈련시킨다.

저자는 그러면 가능한 최고 수익을 생성하기 전에 추가하여 테스트 때 최적의 궤도를 생성하고 이후 조건화를 통해 해당 액션 순서를 생성할 수 있다고 한다. 즉 sequence modeling을 hindsight return 정보와 결합함으로써, 동적 프로그래밍 없이 정책 개선을 할 수 있다고 한다.

2. Preliminaries and Related Work

2.1 autoregressive model

rnn을 생각하시면 됨

RNN과 마찬가지로, 자기 회귀 모형의 출력(시간 t)($h_t$)는 단순히 $x_t$에 의존하지 않는다. 이전 time step 도 영향을 준다. 그러나 RNN과는 달리 이전 x는 일부 숨겨진 상태를 통해 제공되지 않으며 모델에 대한 다른 입력으로 제공된다.

간단히 말해서, autoregressvie model은 과거 값에서 미래 값을 예측하는 피드-포워드 모델일 뿐이다.

2.2 Deadly Triad

우리의 논의가 지금까지 불안정과 공통의 위험 발생할 때마다 모든 다음의 세 가지 요소 중을 합하면 우리는`deadly triad`을 만드는 말로 요약할 수 있다.

- Bootstrapping

- Off-policy learning

- Function approximations (as Neural Nets)

사례

현재 보상을 나아가면 +1 , 점프 -1 , 죽으면 -10이라 하였다고 합니다.

그리고 위에 사진을 보게 되면, 에이전트 입장에서는 크게 혼동이 될 사진입니다.

첫 번째 사진에서는 앞으로 가는 게 맞지만, 두 번째 사진도 에이전트가 보기에는 앞으로 가는 게 나쁘지 않다고 판단할 수 있습니다.

왜냐하면 실제로 첫번째 사진에서는 앞으로 가는 것이 가장 잘 좋은 q-value로 나오게 될 것이고, 2번째도 에이전트가 보기에는 앞으로 전진하는 것이 가장 좋은 값으로 받아들여지게 될 것입니다. 이런 현상은 위의 3가지 요인으로 인한 overestimate 된 현상 때문에 발생하게 된다고 합니다.

2.2 Offline Reinforcement Learning

오프라인 강화 학습에서는 환경 상호 작용을 통해 데이터를 얻는 대신, 우리는 임의의 정책의 궤적 롤아웃으로 구성된 일부 고정 제한 데이터 세트에만 액세스 할 수 있다.

이 설정은 에이전트가 환경을 탐색하고 추가 피드백을 수집할 수 있는 기능을 제거하므로 더 어렵습니다.

2.3 Transformers

sequential data를 효율적으로 모델링하기 위해서 고안하였다. (Vaswani)

residual connections와 함께 self attention layer들의 결합으로 이루어졌다.

2.4 Credit Assignment Problem

지도 학습에서 각 스탭마다 최고의 행동을 안다면,

neural network는 잘 작동할 것이고, 추정된 확률과 타깃 확률 사이에서 cross entropy 도 최소화할 수 있을 것이다.

하지만 강화학습에서는 리워드들을 통하여 오로지 에이전트가 가이드를 받고 있고, 리워드는 굉장히 sparse 하고 delayed 되어 있다.

예) 만약 100개의 step에서 balanace pole를 관리한다고 하면, 100개의 행동 중에 어떤 것은 좋은 것이며, 어떤 것은 나쁜 건 있지 어떻게 알 수 있을까? 내가 여기서 아는 것은 마지막 행동 후에 pole이 떨어지는 것을 알지만, 그렇다고 해서 마지막 행동에 모든 책임이 있다고는 할 수 없을 것이다.

이러한 문제를 credit assignment problem이라 한다.

- 에이전트가 보상을 얻을 때, 그 행동이 칭찬받아야 할지 비난받아야 할지 알기 어렵다.

문제 해결 방법

- 흔한 전략은 전체리워드의 합을 기반으로 액션을 평가한다.

- 각 스탭에 discount factor를 적용한다 (discounted reward의 합은 action들의 보상)

저자들은 transformer를 사용하면, 보상 함수나 critic을 명시적을 학습할 필요 없이 transformer acrhictecture에 자연스럽게 나타날 수 있다고 주장한다.

2.5 Rollout이란?

일반적으로 "롤아웃"이라는 용어는 시뮬레이션을 다룰 때 사용된다. 이는 현재 추정 모델에 따라 인공 에피소드가 생성되는 모델 기반 강화 학습에서 흔히 볼 수 있다. 이 모델은 실제 환경과 매우 다를 수 있습니다.

- Rollout : 데이터 transition {(s,a,s',r)}을 얻기 위해 에이전트와 환경이 1번(or n번) 상호작용 하는 것(sample)을 의미한다. trajectory의 경우 한 에피소드 전체를 바라보고, reward가 포함되어 있지 않지만, Rollout은 한 번의 상호작용을 하고, reward를 포함한다.

롤아웃이 사용되는 또 다른 설정은 계획(예: 몬테 카를로 트리 검색)에서 계획 수립은 어려울 수 있지만 합리적인 정책을 사용하여 가상 에피소드를 쉽게 생성할 수 있다. 이 기능은 훈련 중에 사용할 수 있는 상대가 없는 게임에서는 유용하게 사용할 수 있지만, 자체 정책이나 다른 정책을 사용하여 게임을 시뮬레이션할 수 있습니다.

3 Method

Decision Transformer, which models trajectories autoregressively with minimal modification to the transformer architecture

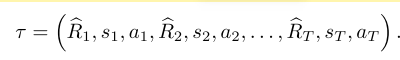

Trajectory representation

궤적 표현 선택에서 핵심 바람직한 데이터는 transformer가 의미 있는 패턴을 학습할 수 있도록 해야 하며(1), 테스트 시간에 조건부적으로 액션을 생성할 수 있어야 한다는 것입니다.(2)

우리는 모델이 과거의 보상이 아니라 미래의 원하는 보상에 기초하여 액션을 생성하기를 원하기 때문에 보상의 모델링은 중요하지 않다고 합니다.

결과적으로 직접적으로 리워드를 받는 대신에 return-to-go $\hat{R_t}=\sum r_{t^'}$를 받게 됩니다.

이는 autoregressive 훈련 및 생성에 적합한 다음과 같은 궤적 표현으로 이어집니다.

테스트 때, 요구되는 성능을 구체화할 수 있습니다(성공하면 1 실패하면 0)

테스트 시간에는 원하는 성능(예: 성공을 위한 1 또는 실패를 위한 0)과 생성을 시작하기 위한 조건부 정보로 환경 시작 상태를 지정할 수 있습니다.

현재 상태에 대해 생성된 동작을 실행한 후 달성된 보상에 의해 목표 수익률을 감소시키고 에피소드가 종료될 때까지 반복합니다.

Architecture

마지막 K timestep을 총 3K 토큰(각각의 modality를 위한 것들, return-to-go, state , action)에 대해 decision transformer에 입력합니다. token embedding을 얻기 위하여, 각각의 modality에 linear layer를 학습한다. 이러한 작업은 raw input을 embedding dimension으로 투영하고 layer normailziation을 합니다.

시각적인 이미지에서는 convolution encoder를 linear layer 대신에 사용합니다.

추가적으로 각 타입 스탭에서 임베딩은 학습되어지고 각 토근에 더해집니다.

(1 time step에 3개의 토큰이 해당하므로 이는 transformer에 사용되는 표준 positional embedding과는 다릅니다.)

그런 다음 token은 auto regressive 모델링을 통해 향후 작업 token을 예측하는 GPT [9] 모델에 의해 처리된다고 합니다.

Training

주어진 offline trajectories dataset이 있다고 할 때, 해당 데이터셋에서 K의 seq length를 미니 배치로 샘플링했다고 합니다. 입력 토큰에 해당하는 예측 헤드는 discrete action에 대한 교차 엔트로피 손실 또는 continous action에 대한 평균 제곱 오류를 사용하여 'a_t'에서 예측하도록 훈련된다. 그리고 각 타임 스탭의 손실들을 average 한다고 합니다.

프레임워크 내에서 쉽게 허용될 수 있지만 성능을 개선하기 위해 state나 return-to-go 를 예측하는 것을 발견하지 못했다고 합니다.

(아마 이 부분에 대해서 다른 사람들이 지도 학습이 아니냐라는 의견이 있고, 공감이 가는 부분이긴 합니다.

그렇지만 한편으로는 손실 함수 부분은 지도 학습과 굉장히 유사하다 볼 수 있지만, 해당 데이터에서 time step으로 서로 간의 관계를 묶어 두기 때문에 iid 하지 않게 되고, 그때 state에서 time step을 고려해서 a_pred라는 값이 나오기 때문에 강화학습이라고도 할 수 있지 않을까라는 근거 없는 의견을 달아봅니다...)

4 Evaluations on Offline RL Benchmarks

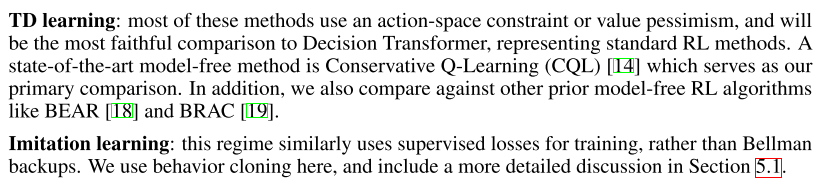

특히, 저자의 주요 비교 포인트는 decision trasformer 아키텍처도 본질적으로 model-free 때문에 TD-Learning에 기반한 model-free offline RL algorithm이라고 합니다.

TD-Learing은 sample efficiency에 대한 RL의 지배적인 패러다임이며, 또한 많은 model-based RL 알고리즘에서 서브루틴으로 두드러지게 나타나게 된다고 합니다.

또한 behavior cloning 및 varints과 비교하는데, 이는 우리와 유사한 likelihood-based 정책 학습 공식도 포함되기 때문입니다.

정확한 알고리즘은 환경에 따라 다르지만 우리의 동기는 다음과 같다고 합니다.

아쉽게도 실험 결과에서 long-term credit assignment이 잘된다고 하는데, 어떻게 잘 되고 있는 지는 없는 것 같아서 아쉽습니다..

5 Discussion

기존과는 다른 방법을 적용한 논문이다 보니, discussion에 대해서도 보기로 하였다.

5.1 Does Decision Transformer perform behavior cloning on a subset of the data?

(decison trasformer는 데이터의 하위 집합에 대해 behavior cloning를 수행합니까?)

이 섹션에서는 decision trasformer가 일정한 수익으로 데이터의 하위 집합에 대해 imitation learning을 수행하는 것으로 생각할 수 있는지 여부를 파악하려고 한다.

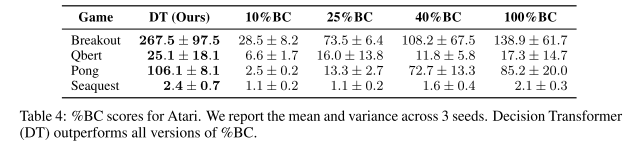

이를 조사하기 위해, 저자는 에피소드 return에 의해 정렬된 데이터 세트의 상위 X% 시간 단계에 대해서만 행동 복제를 실행하는 새로운 방법인 Percentile Bebavior Cloning(% BC)를 제안한다.

즉, return으로 정렬 한 후에, % 기준으로 자르겠다는 의미인 것 같고, 100%로 갈수록 기존 것을 다 사용한다는 의미인 것 같다.

백분위수 X%는 전체 데이터 세트에 대해 훈련하고 관측된 최상의 궤적만 복제하는 표준 BC(X = 100%) 사이에 보간 되며, 데이터의 바람직한 하위 집합에 초점을 맞춘 전문 모델을 교육하여 더 많은 데이터에 대해 훈련함으로써 더 나은 일반화를 교환(trade off)한다.

표 3에서 %BC를 decision trasformer 및 CQL과 비교하여 전체 결과를 보여준다.

cloning를 위한 최적의 부분 집합을 선택할 수 있는 유일한 방법은 환경의 롤아웃(rollouts)을 사용하여 평가하는 것입니다. 따라서 %BC는 현실적인 접근 방식이 아니며, 오히려 decision trasformer의 동작에 대한 통찰력을 제공하는 역할을 합니다.

D4RL 체제에서와 같이 데이터가 풍부할 때, 우리는 %BC가 다른 오프라인 RL 방법과 일치하거나 이길 수 있다는 것을 발견했다.

대부분의 환경에서 decision trasformer는 최상의 %BC의 성능과 경쟁하며, 전체 데이터 세트 배포에 대한 교육을 받은 후 특정 하위 집합에 연결할 수 있음을 나타낸다.

대조적으로, 저자는 1%의 replay buffer를 데이터 세트로 사용하는 아타리와 같은 낮은 데이터 체계를 연구할 때, %BC는 약하다는 것을 확인하였다고 한다.(표 4 참조).

이는 상대적으로 데이터 양이 적은 시나리오에서 decision trasformer가 데이터 세트의 모든 궤적을 사용하여 반환 조건 목표와 다르더라도 일반화를 개선함으로써 %BC를 능가할 수 있음을 시사한다고 주장한다.

결과는 decision trasformer가 단순히 데이터 세트의 하위 집합에 대해 모방 학습을 수행하는 것보다 더 효과적일 수 있음을 나타낸다.

저자가 고려한 작업에서 decision trasformer는 최적의 부분 집합을 선택해야 하는 혼란 없이 %BC보다 성능이 뛰어나거나 경쟁력이 있다고 주장한다.

생각해보면, 기존에 만약 behavior cloning이나 offline rl을 사용할 때 offline dataset도 어떠한 셋을 선택할 지에 따라서 성능이 많이 좌우될 수 있을 것 같다. 저자가 주장하는 것은 decision transformer를 사용하고 어느 정도 좋은 데이터만 있으면, 다른 알고리즘 대비 그렇게 많은 데이터는 필요하지 않을 수 있다는 것 같다.

5.2 How well does Decision Transformer model the distribution of returns?

(decision trasformer는 수익 분포를 얼마나 잘 모형화합니까?)

저자는 광범위한 범위에서 원하는 목표 수익률을 변화시킴으로써 return-to-go token을 이해하는 decision transformer의 능력을 평가했다고 한다.

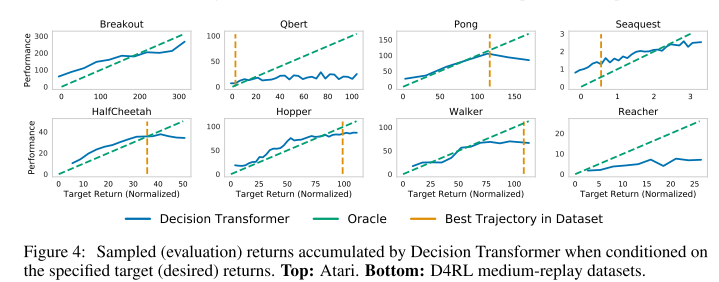

transformer의 다중 작업 분포 모델링 능력 평가(아래 그림)는 다양한 목표 수익률 값에 대한 평가 에피소드 과정에서 에이전트가 축적한 평균 표본 수익률을 보여준다.

모든 작업에서 원하는 대상 반환과 실제 관찰된 반환은 높은 상관 관계를 가집니다. Pong, Half Cheetah 및 Walker와 같은 일부 작업에서 의사 결정 변환기는 (오라클 선과의 겹침으로 표시) 원하는 수익과 거의 완벽하게 일치하는 궤적을 생성한다.

기대하는 성능과 decision transformer가 일치하는 형태를 띠고 있으니, 잘 모형화했다? 이런 느낌...

5.3 What is the benefit of using a longer context length?

(문맥 길이가 길어지면 어떤 이점이 있는가?)

이전 상태, 작업 및 반환에 대한 액세스의 중요성을 평가하기 위해 컨텍스트 길이 K를 요약합니다. 이는 일반적으로 이전 상태(즉, K = 1)가 프레임 적층 사용 시 강화 학습 알고리듬에 충분하다고 간주되기 때문에 흥미롭다고 합니다.

표 5는 K = 1일 때 의사 결정 변환기의 성능이 크게 저하되는 것을 보여 주며, 과거 정보가 아타리 게임에 유용하다는 것을 나타냅니다. 한 가지 가설은 시퀀스 모델링과 같이 정책의 분포를 나타낼 때 변환기가 어떤 정책이 동작을 생성했는지 식별할 수 있도록 허용하여 더 나은 학습 및/또는 훈련 역학을 향상한다는 것이다.

즉, 길이에 따라서 성능적으로 영향이 있고, context length를 길게 하면 더 성능 향상을 할 수 있다고 주장합니다.

5.4 Does Decision Transformer perform effective long-term credit assignment?

(decision transformer 가 long-term credit assignment를 효과적으로 수행하나요?)

우리 모델의 long-term credit assignment을 평가하기 위해, 우리는 key-to-door 환경의 변형을 고려했다고 합니다.

이것은 세 단계의 순서를 가진 그리드 기반 환경입니다.

(1) 첫 번째 단계에서 에이전트는 키가 있는 룸에 배치되고, (2) 에이전트는 빈 룸에 배치되며,

(3) 마지막으로 에이전트는 문이 있는 룸에 배치됩니다.

에이전트는 세 번째 단계에서 도어에 도달할 때 binary 보상을 받지만, 첫 번째 단계에서 키를 집어든 경우에만 보상을 받습니다. 저자는 표 6에 무작위 동작을 적용하여 생성된 궤적의 데이터 세트를 교육하고 성공률을 보여줍니다.

decision trasformer 모델과 %BC(성공적인 에피소드에 대해서만 훈련)는 무작위 보행에 대한 훈련에도 불구하고 거의 최적에 가까운 경로를 생성하는 효과적인 정책을 학습할 수 있다.

그러나 TD Learning(CQL)은 관련된 long horizons에 걸쳐 Q-value을 효과적으로 전파할 수 없으며 성능이 떨어진다.

즉, 랜덤하게 한 상황에서도 중요한 정보를 잘 캐치해서 어디에 어떤 정보가 어떻게 영향을 줬는지(credit assignment)를 잘 학습했다고 주장하고 있습니다.

5.5 Can transformers be accurate critics in sparse reward settings?

(transformer가 희소 보상 설정에서 정확한 비평가가 될 수 있는가?)

5.4에서 효율적인 정책을 생성할 수 있는 transformer를 사용하여, 효과적인 비평가가 될 수 있는지도 평가한다고 합니다. Key-to-Door 환경에서 작업 토큰 외에도 반환 토큰을 출력하도록 decison transformer를 수정했다고 합니다.

transformer가 아래 그림(왼쪽)에 표시된 에피소드 중 이벤트를 기반으로 보상 확률을 지속적으로 업데이트한다는 것을 발견했다. 또한, transformer가 그림 5(오른쪽)에 표시된 에피소드에서 중요한 이벤트에 참석한다는 것을 발견하며, 라포소 외에서 논의된 바와 같이 state-reward 연관성의 구성을 나타낸다. [25]이며 정확한 값 예측이 가능합니다.

5.6 Does Decision Transformer perform well in sparse reward settings?

(sparse reward에서도 잘 수행할 수 있는가?)

TD 학습 알고리즘의 알려진 약점은 우수한 성과를 내기 위해 밀집된 보상이 필요하다는 것인데, 비현실적이거나 비용이 많이 들 수 있다.

대조적으로, decision transformer는 보상의 밀도에 대해 최소한의 가정을 하기 때문에 이러한 설정에서 견고성을 개선할 수 있다고 합니다.

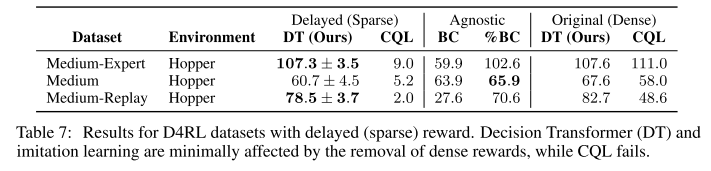

이를 평가하기 위해 에이전트가 궤적을 따라 어떠한 보상도 받지 않고 대신 마지막 시간 단계에서 궤적의 누적 보상을 받는 D4RL 벤치마크의 지연 반환 버전을 고려했다고 합니다.

delayed reward에 대한 우리의 결과는 아래 표에 나와 있습니다.

delayed reward은 decision transformer에 최소한 영향을 미치며, 훈련 프로세스의 특성으로 인해 imitation learning 방법은 reward에 구애받지 않는다.

TD Learning(CQL)은 붕괴되지만, decision trasformer와 %BC는 여전히 좋은 성과를 거두어 decsion transformer가 지연된 보상에 더 강력할 수 있음을 보여준다.

5.7 Why does Decision Transformer avoid the need for value pessimism or behavior regularization?

decision transformer와 이전 offline RL 알고리즘의 한 가지 중요한 차이점은 우수한 성능을 달성하기 위해 policy regularization 또는 conservatism(보수성)이 필요하지 않다는 것이다.

저자의 추측은 TD Learning 기반 알고리듬이 대략적인 value function를 학습하고 이 value function를 최적화하여 policy을 개선한다는 것이다.

학습된 함수를 최적화하는 이러한 행위는 value function 근사치의 부정확성을 악화시키고 악용하여 policy improvement에 실패를 초래할 수 있다.

decision transformer는 학습된 함수를 목표로 사용하는 명시적 최적화를 요구하지 않기 때문에 정규화 또는 보수화의 필요성을 피한다. (어떤 부분 때문에 명시적 최적화를 요구하지 않는지 이해 안 됨...)

5.8 How can Decision Transformer benefit online RL regimes?

offline RL과 행동을 모델링하는 능력은 하위 테스크에 대해 샘플 효율적인 online RL을 가능하게 하는 잠재력을 가지고 있다. offline에서 online으로의 전환을 연구한 연구는 일반적으로 sequence modeling 목표와 같은 likehood-based 접근법이 더 성공적이라는 것을 발견했다고 한다.

[26] Yang Gao, Huazhe Xu, Ji Lin, Fisher Yu, Sergey Levine, and Trevor Darrell. Reinforcement learning from imperfect demonstrations. arXiv preprint arXiv:1802.05313, 2018.

[27] Ashvin Nair, Murtaza Dalal, Abhishek Gupta, and Sergey Levine. Accelerating online rein- forcement learning with offline datasets. arXiv preprint arXiv:2006.09359, 2020.

[28]

비록 저자는 이 일에 offline rl을 연구한 결과로 decision transformer가 의미 있게 behavior generation에 대한 강력한 모델로 일하며 온라인 실생활 방법을 개선할 수 있다고 믿는다고 한다.

예를 들어, decision transformer가 강력한 “memorization engine”과 Go-Explore [28]과 같은 강력한 exploration 알고리즘과 함께 다양한 행동 세트를 동시에 모델링하고 생성할 수 있는 잠재력을 가지고 있다고 믿는다.

Conclusion

저자들은 sequential modeling + 강화학습을 통합한 decision trasformer를 제안함

우리는 이 연구가 RL에 대형 transformer 모델을 사용하는 것에 대한 더 많은 조사를 불러일으키기를 바란다. 우리는 실험에 효과적인 간단한 감독 손실을 사용했지만 대규모 데이터 세트에 대한 애플리케이션은 자체 감독 사전 훈련 작업의 이점을 얻을 수 있다고 함.

또한, 예를 들어 결정론적 수익률 대신 확률적 설정을 모델링하기 위한 수익률 분포 조건화 등 수익률, 상태 및 작업에 대한 보다 정교한 임베딩을 고려할 수 있다 함.

transformer 모델은 또한 궤적의 상태 진화를 모델링하는 데 사용될 수 있으며, 잠재적으로 모델 기반 RL의 대안으로 기능할 수 있을 것이라 생각함

실제 애플리케이션의 경우 transformer가 MDP 설정에서 발생하는 오류 유형과 탐색이 부족한 부정적 결과를 이해하는 것이 중요하다. 특히 의심스러운 소스에서 나올 수 있는 더 많은 데이터로 RL 에이전트를 보강하는 연구를 고려할 때 destructive biases을 추가할 수 있는 모델을 훈련하는 데이터 세트를 고려하는 것도 중요할 것이다.

예를 들어, 다양한 행위자에 의한 보상 설계는 우리의 모델이 원하는 수익을 조건으로 하여 행동을 생성하므로 잠재적으로 의도하지 않은 행동을 발생시킬 수 있다.

즉, 결과에 대한 이해를 할 때 transformer가 유용할 것이라 함.

자체 결론

크게 수식적인 부분에 대한 증명 없이 그냥 잘된다라는 말만 하고 있는 것 같아서 참신하긴 하지만 뭔가가 아쉽다.

저자가 말한 것처럼 transformer가 순차적인 것에 대해서는 분명히 잘할 것 같기는 한데, 전반적으로 업데이트하는 방식이라던지, 주장하고 있는 것들에 대해서는 명확하게 잘 보인 것 같지는 않다.

그래도 개인적으로는 새로운 관점에서 볼 수 있었던 것 같고, 특히 이러한 구조로 갔을 때 credit assignment 관점에서 보면, 현재 구조보다는 이 구조가 특정 행동에 대한 평가가 잘 이루어지지 않을까 싶다.

Reference

'관심있는 주제 > RL' 카테고리의 다른 글

| Paper) Multi-Agent Game Abstraction via Graph Attention Neural Network (0) | 2021.07.03 |

|---|---|

| Paper) PettingZoo (MARL Environment) 논문 읽어보기 (0) | 2021.06.19 |

| RL) DuelingDQN 알아보기 (0) | 2021.06.03 |

| Paper) Reward is Enough 관련 자료 (4) | 2021.05.31 |

| 현대 게임 이론이 다중 에이전트 강화 학습 시스템에 미치는 영향 -글 리뷰 (0) | 2021.05.27 |