간단하게 확인해보기

MultiAgent RL에서 에이전트 수가 많고 복잡한 게임 관계로 인해 POLICY LEARNING에 많은 어려움을 겪는다고 한다.

그래서 학습 과정을 단순화하는 것도 MARL에서는 중요한 연구 대상이다.

대부분 MARL에서 지역적으로 에이전트 간의 상호작용이 발생하는 경우가 많아서, 다른 모든 에이전트에 대한 것들을 다 조정할 필요는 없습니다.

기존 방법에서는 미리 정의된 규칙을 사용하여 에이전트 간의 상호 작용 관계를 확보하려고 합니다. 그러나 에이전트 간의 복잡한 상호작용을 규칙으로 변환하기가 어렵기 때문에 대규모 환경에서는 방법을 직접 사용할 수 없습니다.

그래서 본 논문에서는 COMPLETE GRAPH로 에이전트 간의 관계를 모델링하고, 두 에이전트 간의 상호 작용 여부와 상호작용 중요성을 나타낼 수 있는 TWO-STAGE ATTENTION NETWORK(G2 ANET)을 제안한다고 합니다.

G2 ANET을 기반으로 한 새로운 게임 추상화 메커니즘을 제공합니다.

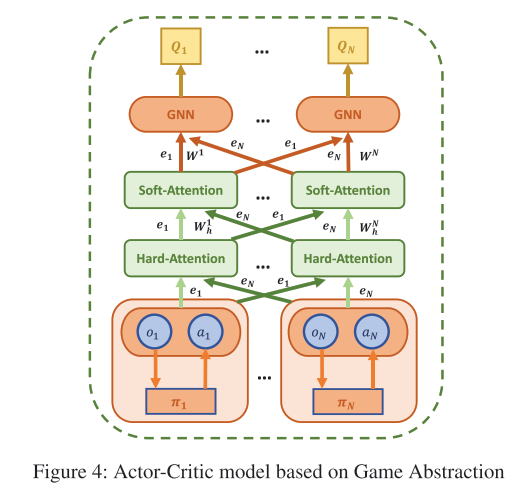

게임 추상화 수행을 위한 그래프 신경만 기반의 MARL에 이러한 검출 메커니즘을 통합하고 2가지 새로운 학습 알고리즘(GA-Command, GA-AC)을 제안하기도 합니다.

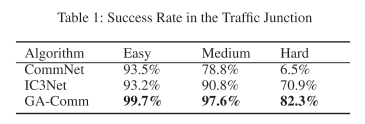

저자들은 Traffic Junction이나 Predator-Prey에서 실험을 하였습니다.

저자들은 이 방법이 학습 과정을 단순화하고, 최신 것보다 더 나은 성능을 낸다고 주장합니다

즉 기존 방식들이 아시다시피, 해당 에이전트와 근처에 있는 에이전트들을 이용해서 하는 반면에 이렇게 실제로 적용하기 어려우니 그래프라는 것을 도입하고 거기다가 알아서 연결성을 학습하여 큰 시스템에도 적용하기 위해서 Graph와 Attention을 MARL에 적용한 논문인 것 같다.

(1) Policy network in communication model (GA Command):

Each agent considers the communication vectors of all other agents when making decisions;

(2) Critic network in actor critic model (GA-AC):

Critic network of each agent considers the state and action information of all other agents when calculating its Q-value in AC-based methods.

실험

본 논문의 핵심은 멀티 에이전트의 POLICY LEARNING을 간소화하는 데 중점을 두고 있다.

gnn과 attention을 사용하여, 게임 추상화를 했다고 한다.

에피소드의 여러 다른 time step에서 에이전트 간의 관계는 끊임없이 변화하며, 그 사이에서 adaptive and dynamic attention value를 배울 수 있게 된다고 한다.

MARL로 갈수록 문제의 복잡도가 늘어나니, 일반화된 틀이 없고 다양하게 구성하는 것이 많은 것 같다는 생각이 들었다.

다 자기가 풀고자 하는 문제에 맞게 잘 변형해서 쓰는 것 같다.

| 설명 | URL |

| Multi-Agent Game Abstraction via Graph Attention Neural Network | https://arxiv.org/abs/1911.10715 |

'관심있는 주제 > RL' 카테고리의 다른 글

| Paper) Reinforcement Learning for Solving the Vehicle Routing Problem (0) | 2021.08.21 |

|---|---|

| RL) Reinforcement Learning for Portfolio Management - 논문 (0) | 2021.07.19 |

| Paper) PettingZoo (MARL Environment) 논문 읽어보기 (0) | 2021.06.19 |

| Paper) Decision Transformer: Reinforcement Learning via Sequence Modeling (0) | 2021.06.08 |

| RL) DuelingDQN 알아보기 (0) | 2021.06.03 |