2020년 4월 29일 날 논문

아직 accept이 될지는 모르겠지만, 일단 간단하게 살펴보기

기존 DNN은 뛰어난 성능을 보이지만, 어떻게 결정을 내리는지 대게 불분명하기 때문에, 해석성 측면에서 손실이 생긴다.

그래서 해석성을 할 수 있는 NAM이라는 것을 주장하고, 여기서 주장하는 NAM(Neural Additive Models)는 각 인풋 변수에 관여하는 신경망의 선형 결합을 학습한다고 함.

아래 그림 처럼 하나의 인풋에다가 각각의 뉴럴 네트워크를 만들어서 하겠다는 것인데, 흐음... 괜찮을지는 의문이긴 함.

결국 상관성은 고려하지않고, 각 독립변수에 대해서 네트워크를 만든다는 느낌?

NAM은 GAM(Generalized Additive Models) 중에 하나

GAM 중에서 NAM을 쓰면 이러한 장점이 있다고 함.

overfitting 되는 것을 방지하기 위해? ExU 제안한다고 함.

ExU는 신경망의 표현성을 향상하지는 않지만 점프 기능을 맞추기 위한 학습성을 향상한다.

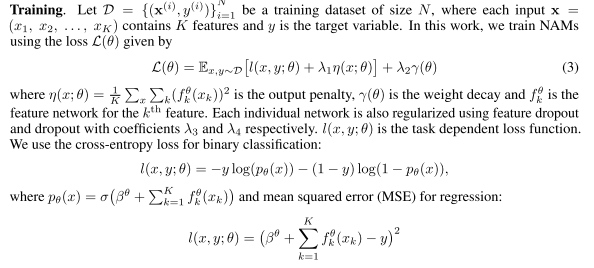

먼가 정규화를 엄청 거는 것을 알 수 있음.

아래에 $l(x, y;\theta)$ 는 어떤 문제를 푸냐에 따라 cross entorpy or mse로 함.

사실 이 글을 읽어보려고 한 이유도 이 시각화 결과물 때문에 찾아보게 됨.

뉴럴 네트워크로 했는데 스케일을 유지하면서, Risk를 표현한 것이 굉장히 인상 깊었다.

그러면 알고리즘 자체에서 표준화 같은 것을 안 하고 넣는다는 의미인지? 이 부분은 특별한 언급이 없는 것 같았다.

먼가 범주형 변수를 해석하는 것에서는 신기하긴 했지만, 일반적으로 알고 있는 선형 회귀처럼 층이 생기는 것 같다.

결과물

NAM이라는 GAN에 Neural Network를 쓴 것인데, 변수 각각의 대한 영향도는 계산할 수 있어서 신기했지만, 상관성을 고려하지 않아서 아쉽다? 그래도 흥미로웠다!

https://arxiv.org/abs/2004.13912

Neural Additive Models: Interpretable Machine Learning with Neural Nets

Deep neural networks (DNNs) are powerful black-box predictors that have achieved impressive performance on a wide variety of tasks. However, their accuracy comes at the cost of intelligibility: it is usually unclear how they make their decisions. This hind

arxiv.org

'관심있는 주제 > XAI' 카테고리의 다른 글

| Permutation importance 을 사용하여 딥러닝 모델 해석하기 (정형 데이터) (0) | 2020.03.26 |

|---|---|

| Interpreting complex models with SHAP values - 리뷰 (0) | 2020.02.29 |

| 텐서플로우 버전 1에서 LIME 과 SHAP 을 사용하여 모델 해석하기 (정형 데이터) (5) | 2020.02.25 |

| [ Python ] SHAP (SHapley Additive exPlanations) Decision plot 설명 (0) | 2019.09.08 |