https://news.hada.io/topic?id=22449

GPT-OSS vs. Qwen3 및 GPT-2 이후 LLM 아키텍처 발전 상세 비교 | GeekNews

OpenAI가 gpt-oss-20b/120b 모델을 오픈 가중치로 공개함에 따라 2019년 GPT-2 이후 처음으로 OpenAI의 대형 공개 가중치 LLM이 등장함gpt-oss 모델은 GPT-2와 비교해 Dropout, Absolute Position Embedding, GELU 등을 효율

news.hada.io

https://magazine.sebastianraschka.com/p/from-gpt-2-to-gpt-oss-analyzing-the

From GPT-2 to gpt-oss: Analyzing the Architectural Advances

And How They Stack Up Against Qwen3

magazine.sebastianraschka.com

GPT-OSS 아키텍처 알아보기

핵심은 MoE(전문가 혼합) 기반 디코더-온리 트랜스포머에, 교대형 슬라이딩 윈도우 어텐션(128 토큰), GQA, RoPE+YaRN, RMSNorm과 SwiGLU 계열 FFN을 결합해 추론 효율과 긴 컨텍스트를 동시에 잡았다는 점입니다. 또한 MXFP4(4.25-bit) 양자화를 MoE 가중치에 적용해 120B는 80GB, 20B는 16GB 메모리 단일 GPU에서도 구동되도록 설계했습니다

1. GPT-2 → GPT-OSS: 핵심 변화 요약

| 영역 | GPT-2(2019) | GPT-OSS(2025) | 변화 의미 |

| 정규화 | LayerNorm (Post-LN) | RMSNorm (Pre-LN) | 연산 효율↑, 학습 안정성↑ |

| 위치 인코딩 | 절대 위치 임베딩 | RoPE + YaRN 확장 | 긴 문맥(최대 131k 토큰) 처리 |

| FFN 구조 | 2-layer FFN + GELU | MoE(전문가 혼합) + SwiGLU | 파라미터 용량↑·추론비용↓, 표현력↑ |

| 어텐션 | Dense MHA 전층 | 교대형 Dense ↔ Sliding Window(128토큰) + GQA | 메모리 절감, 장·단거리 밸런스 |

| 드롭아웃 | O | X | 대규모 단일 에폭 학습에서 불필요, 성능↑ |

| 활성화 함수 | GELU | SwiGLU | 매개변수 효율, 학습 안정성↑ |

| 주의 메커니즘 | 일반 softmax attention | bias unit + learned attention sinks | 특수 위치 집중 제어 |

| 양자화 | 지원 없음 | MXFP4 (MoE 가중치만) | 단일 GPU(20B=16GB, 120B=80GB) 가능 |

2. 구조적 혁신 포인트

(1) MoE + SwiGLU

- GPT-2: 모든 토큰이 동일한 FFN을 통과.

- GPT-OSS: 토큰별 top-4 전문가만 활성되는 MoE.

- 120B: 전문가 128명, 20B: 전문가 32명.

- SwiGLU로 비선형성과 매개변수 효율을 동시에 확보.

- 효과: 총 파라미터 수는 대폭↑, 활성 파라미터는 제한→ 추론 효율 극대화.

(2) 교대형 Sliding Window Attention

- GPT-2: 전층 Dense Attention → 컨텍스트 전체 연산.

- GPT-OSS: Dense ↔ 128토큰 윈도우를 교대로 배치.

- Dense 층: 장거리 의존성 유지.

- 윈도우 층: 최근 문맥만 집중 → 메모리/연산 절감.

- GQA(Grouped Query Attention)로 KV 메모리 절감까지 병행.

(3) RoPE + YaRN

- GPT-2: 절대 위치 임베딩 → 긴 문맥 학습 어려움.

- GPT-OSS: RoPE로 상대 위치 정보를 각도 회전으로 부호화.

- YaRN 확장: RoPE 스케일을 조정해 131,072 토큰까지 커버.

(4) 드롭아웃 제거

- 대량 데이터 단일 에폭 학습에서 드롭아웃이 오히려 일반화에 불리하다는 최근 연구 반영.

- 추론 일관성과 성능 안정성 확보.

(5) MXFP4 양자화

- GPT-2에는 없던 4.25bit 블록 스케일 양자화를 MoE 가중치에만 적용.

- 파라미터 메모리의 90% 이상 절약.

- 120B: H100 80GB 1장 / 20B: 최신 RTX 50xx 16GB로 단일 카드 구동 가능.

(6) Attention Bias & Sinks

- GPT-2 시절 방식인 attention bias를 변형 적용.

- learned bias logit을 각 head에 더해 “항상 주목하는 위치”를 구현.

- 최근 연구에선 효과가 제한적이라 논란은 있지만, 안정화 트릭으로 채택.

3. Qwen3와의 비교

- 스케일링 방향: gpt-oss는 넓고 얕음(폭↑, 깊이↓), Qwen3는 좁고 깊음.

- MoE 전략: gpt-oss=소수 대형 전문가, Qwen3=다수 소형 전문가.

- 어텐션 설계: gpt-oss=교대형 슬라이딩 윈도우, Qwen3=전층 전역.

1) Qwen3의 깊이(Depth) 강조

- Qwen3: Transformer 블록 48개

→ gpt-oss-20B의 2배 깊이 (24개 블록). - 깊은 아키텍처는 같은 파라미터 수에서 표현력·모델링 유연성을 높일 수 있음.

- 다만 폭발/소실 그래디언트로 인한 학습 난이도가 증가하며, 이를 완화하기 위해 RMSNorm과 shortcut connection 같은 안정화 기법이 필요.

2) gpt-oss의 폭(Width) 대비

- gpt-oss:

- 임베딩 차원 2880 (Qwen3: 2048)

- FFN(전문가) 중간 차원도 2880 (Qwen3: 768)

- 어텐션 헤드 수도 2배 많지만, 폭 자체는 임베딩 차원으로 결정됨.

- 폭이 넓은 모델은 추론 시 병렬화 효율↑, tokens/sec 처리량↑, 다만 메모리 사용량 증가.

3) 어느 쪽이 더 나은가?

- 일반 경향:

- 깊이↑ → 표현력·추론 경로 복잡성↑, 학습 난이도↑

- 폭↑ → 추론 속도↑, 메모리 사용↑

- Gemma 2 논문(Table 9) 아블레이션:

- 9B 파라미터 기준, 넓은 모델이 소폭 우세 (평균 52.0점 vs 깊은 모델 50.8점, 4개 벤치마크 평균).

- 하지만 데이터셋·파라미터 크기 동일 조건의 연구는 아직 제한적.

🔍 정리:

Qwen3는 깊이에서, gpt-oss는 폭에서 각각 설계 최적화를 택한 모델입니다.

Qwen3의 48층 깊이 구조는 복잡한 관계 학습과 세밀한 추론 경로 확보에 강점이 있을 수 있지만, 그만큼 학습 안정화와 리소스 요구가 높습니다. gpt-oss는 폭을 키워 추론 효율과 처리량에 더 초점을 맞춘 반면, Qwen3는 깊이 중심의 고표현력 모델링을 지향합니다.

아키텍처 차이 (GPT-OSS 20B vs GPT-OSS 120B)

아키텍처 차이

| 항목 | GPT-OSS 20B | GPT-OSS 120B | 비고 |

| Transformer 블록 수 | 24층 | 36층 | 깊이 확장 |

| 전문가(MoE) 수 | 32명 | 128명 | 전문가 규모 확장 |

| Top-k 활성 전문가 수 | 4명 | 4명 | 동일(토큰당 4명 활성) |

| 임베딩 차원 | 2880 | 2880 | 동일(폭 유지) |

| GQA 헤드 구성 | 64 쿼리 헤드 / 8 KV 헤드 | 동일 | KV 공유 구조 동일 |

| 윈도우 어텐션 | 교대형 Dense ↔ 128토큰 윈도우 | 동일 | 패턴 동일 |

| 활성 파라미터(토큰당) | 약 3.6B | 약 5.1B | 활성 연산량 증가 |

| 총 파라미터 수 | 약 20.9B | 약 116.8B | 전체 용량 5.6배↑ |

| 컨텍스트 길이 | 131,072 토큰 | 동일 | RoPE+YaRN 확장 |

성능/추론 특성

- 20B

- 활성 파라미터 적어 추론 속도 빠름.

- PoC·중소형 GPU 환경에 적합.

- 복잡한 reasoning 성능은 120B 대비 낮지만, 경량 모델로 효율성이 높음.

- 120B

- 활성 파라미터 5.1B로 복잡한 reasoning과 장문맥 처리에서 더 높은 정확도 기대.

- 대규모 모델 특성상 지연시간·메모리 사용량↑.

- 고성능 GPU(H100·MI300X) 단일 노드에서 구동 가능.

운영/배포 차이

| 항목 | GPT-OSS 20B | GPT-OSS 120B |

| MXFP4 메모리 요구량 | 16GB VRAM(최신 RTX 50 시리즈 이상 권장) | 80GB VRAM(H100 등) |

| MXFP4 미지원 시 | bfloat16 기준 약 48GB 필요 | 240GB 이상 필요 |

| 적합 환경 | 로컬·온프레미스 실험, 빠른 응답·낮은 비용 | 클라우드/고성능 서버, 고난도 추론·고품질 응답 |

| Reasoning Effort 토글 | 동일 지원 | 동일 지원 |

정리

- GPT-OSS 120B는 20B의 폭(width)은 유지하면서 **깊이(depth)**와 전문가 수를 늘린 대규모 확장판입니다.

- 20B는 실행 환경 제약이 적고 빠른 추론이 장점, 120B는 추론 품질과 reasoning 능력 극대화가 장점입니다.

- 두 모델 모두 동일한 현대 LLM 설계 스택을 공유하므로, 환경·목표 성능·비용에 따라 선택하면 됩니다.

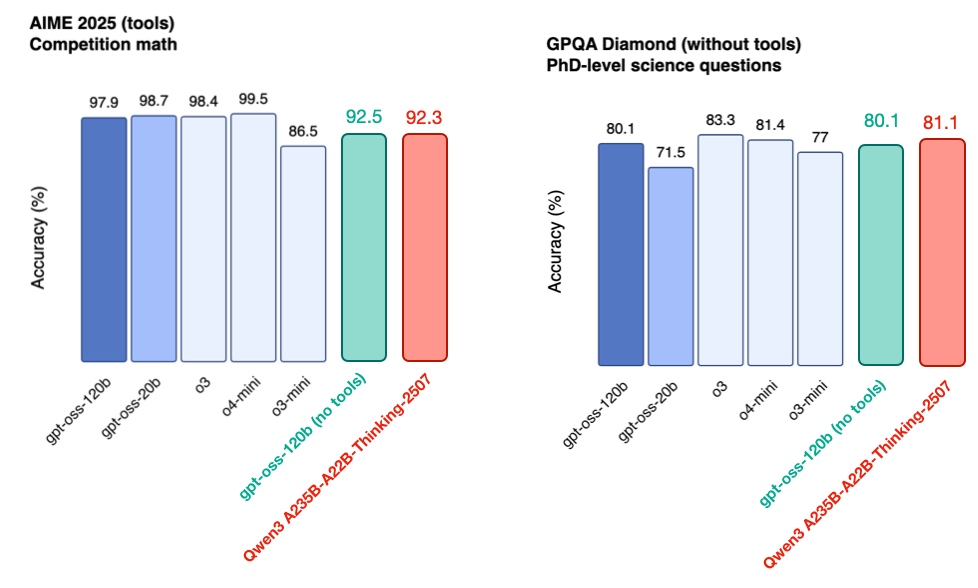

벤치마크

'꿀팁 분석 환경 설정 > GPTs' 카테고리의 다른 글

| Cloudflare down 으로 인한 ChatGPT 사용 불가 이슈 (0) | 2025.11.18 |

|---|---|

| 나노바나나 시스템 프롬프트 분석해보기 (0) | 2025.09.12 |

| GPT-5 성능 지표 및 API 알아보기 (2) | 2025.08.09 |

| ChatGPT-공부하기(Study and learn) 기능 알아보기-250803 기준 (12) | 2025.08.03 |

| ChatGPT는 어떻게 나를 기억할까? 메모리 기능과 관리법 (202506까지) (0) | 2025.06.21 |