오랜만에 강화학습 관련 논문 읽어보기

개요

기존의 휴리스틱 알고리즘은 현실 세계의 제약을 충분히 반영하지 못하고 물류 성능을 정확하게 예측하는 데 한계가 있었습니다.

이 논문은 자동차 도장 공정의 색상 배칭 재순서화 문제를 최적화하기 위해 Heuristic Algorithm-based Action Masking Reinforcement Learning (HAAM-RL)이라는 새로운 강화 학습 접근 방식을 제안합니다.

주요 기여 요소

- 새로운 강화 학습 마르코프 결정 프로세스(MDP) 개발:

FlexSim 시뮬레이터를 사용하여 환경을 설정하고 상태와 행동 공간을 정의합니다.

상태는 시스템의 모든 슬롯을 나타내는 2D 배열로 구성됩니다. - 휴리스틱 알고리즘을 사용한 액션 마스킹:

초기에는 MDP를 수정하여 기본 RL 알고리즘을 적용하려 했으나 만족스러운 결과를 얻지 못했습니다. 이를 해결하기 위해 휴리스틱 알고리즘을 사용한 액션 마스킹 방법을 채택했습니다.

LP(Lowest Priority), CM(Color Memory), UCM(Unseen Color Memory)와 같은 다양한 휴리스틱 알고리즘을 연구하고 구현하여 액션 공간을 줄였습니다. - 앙상블 추론 방법론 적용:

다양한 신경망 하이퍼파라미터와 보상 조정으로 여러 RL 모델을 수집한 후, 하드 보팅(hard voting)과 소프트 보팅(soft voting) 방법을 사용하여 모델 평가를 수행했습니다. - MLOps 플랫폼인 BakingSoDA와 FlexSim의 통합:

사용자 정의 강화 학습 환경을 개발하고, 외부 시뮬레이터인 FlexSim과의 통합을 통해 RL의 훈련 및 추론 단계를 지원합니다.

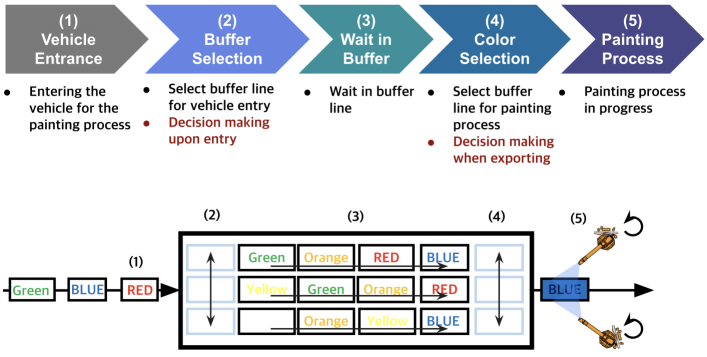

아래 그림은 차량 도장 공정의 단계를 시각적으로 설명합니다.

여기서 크게 의사결정이 필요한 부분이 2가지 있다고 논문에서는 말합니다

- 차량 입장 시 버퍼 선택 (Buffer Selection upon Vehicle Entrance):

- 의사결정 필요성: 차량이 입장할 때 어떤 버퍼 라인으로 보낼지 결정해야 합니다.

- 강화학습의 역할: 에이전트는 입장 시 차량의 현재 상태(예: 색상, 차량 수 등)를 기반으로 최적의 버퍼 라인을 선택하도록 학습합니다. 이를 통해 버퍼의 효율적인 사용과 대기 시간을 최소화할 수 있습니다.

- 버퍼에서 도장 공정으로 이동 시 색상 선택 (Color Selection when Moving to Painting Process):

- 의사결정 필요성: 차량이 도장 공정으로 이동할 때 어떤 버퍼 라인으로 보낼지 결정해야 합니다.

- 강화학습의 역할: 에이전트는 차량의 현재 상태와 버퍼의 상태(예: 현재 대기 차량 수, 색상 등)를 고려하여 최적의 이동 경로를 결정합니다. 이는 도장 공정의 효율성을 높이고 색상 변경 횟수를 줄이는 데 기여합니다.

강화학습

State Space

Action Space

- 에이전트가 취할 수 있는 모든 가능한 행동의 집합입니다. 예를 들어, 차량을 특정 버퍼로 이동시키거나 도장 공정을 시작하는 등의 행동이 포함됩니다. (Discrete Action)

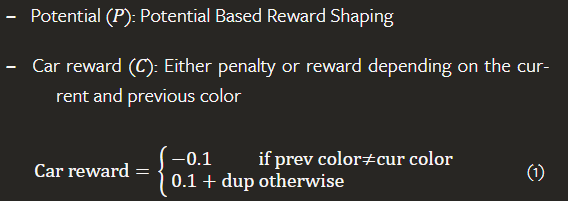

Reward

ActionMasking

액션 마스킹은 강화학습에서 특정 상황에서 유효하지 않은 행동을 제거하여 에이전트의 학습 속도를 높이고 안정성을 향상하는 기술입니다. 이 논문에서는 여러 휴리스틱 알고리즘을 사용하여 액션 마스킹을 구현했습니다.

- 휴리스틱 알고리즘을 사용한 액션 마스킹:

- LP (Lowest Priority): 버퍼 입력에 적용되며, 가장 적게 채워진 버퍼에 차량을 삽입합니다.

- CM (Color Memory): 버퍼의 입력과 출력 모두에 적용되며, 차량의 색상이 마지막 차량과 같은 버퍼에 삽입합니다.

- UCM (Unseen Color Memory): 버퍼 출력에만 적용되며, 마지막으로 추출된 차량의 색상과 다른 차량을 추출합니다.

- 액션 마스킹의 적용:

- 각 상태에서 유효하지 않은 행동을 마스킹하여 선택할 수 없도록 합니다. 예를 들어, 특정 버퍼가 가득 찬 경우 해당 버퍼로의 이동을 마스킹합니다.

- 이를 통해 에이전트가 선택해야 할 행동의 수를 줄여 학습 속도를 높이고, 학습의 안정성을 향상시킵니다.

추론 - 앙상블

앙상블 추론 방법은 여러 신경망 모델을 결합하여 성능을 향상하는 기법입니다. 이 논문에서는 두 가지 앙상블 방법을 사용하여 FlexSim 시뮬레이터에서 RL 모델을 평가합니다: 하드 보팅(hard voting)과 소프트 보팅(soft voting).

- 하드 보팅 과정:

- 각 모델의 출력을 모아 가장 많이 선택된 행동을 계산합니다.

- 이 값이 미리 정의된 임계값을 초과하면, 하드 보팅을 사용하여 최종 행동을 선택합니다.

- 소프트 보팅 과정:

- 각 모델의 로짓 값을 정규화합니다.

- 정규화된 값들을 합산하여 가장 큰 값을 가진 행동을 선택합니다

결론

HAAM-RL은 강화학습과 휴리스틱 알고리즘의 결합을 통해 기존 방법보다 뛰어난 성능을 보여주었으며, 특히 색상 변경 횟수를 최소화하고 안정적인 성능을 보이는 데 효과적이었습니다.

이 연구는 자동차 도장 공정뿐만 아니라 복잡한 제조 공정 전반에 걸쳐 RL의 실제 적용 가능성을 입증합니다.

이와 같은 접근 방식은 향후 다른 제조 공정이나 복잡한 시스템에서도 적용될 수 있으며, RL과 휴리스틱 알고리즘의 결합을 통해 최적의 의사결정을 지원할 수 있습니다.

'관심있는 주제 > RL' 카테고리의 다른 글

| 논문 리뷰) [TODO] Online Decision Transformer (0) | 2022.05.25 |

|---|---|

| [RL] PPO 학습 중에 nan 나오는 특이한 경우 (5) | 2022.05.12 |

| 진행중) Reverb: a framework for experience replay 알아보기 (0) | 2021.10.07 |

| RL) MARL 자료 모음 (2) | 2021.09.25 |

| Paper) Neural Combinatorial Optimization with Reinforcement Learning - Not Finished... (0) | 2021.09.14 |