앙상블 학습 방법 사용의 장점

- 앙상블 기법을 솔로 모델과 비교하면 앙상블 방법이 더 큰 예측 정확도를 제공한다.

- 편중(bias)과 분산(variance)은 앙상블을 통해 줄일 수 있다.

- 대부분의 경우 모델의 과적합 또는 과소적합이 방지됩니다.

- 앙상블 모델은 더 안정적이고 노이즈가 적다.

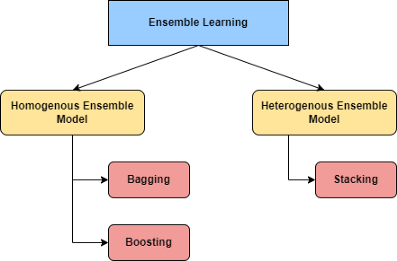

앙상블 테크닉 정리

1. Bagging - 단일 데이터세트를 인스턴스별로 하위 집합으로 나눕니다(병렬로 작동)

2. Boosting - 단일 데이터세트를 인스턴스별로 하위 집합으로 나눕니다(순차적으로 작동).

3. Stacking - 다른 분류기 사용

Bagging

배깅의 목표는 많은 모델의 출력을 통합하여 보다 정확한 결과를 제공하는 것이다.

그러나 문제는 모든 모델을 동일한 데이터 집합을 사용하여 만든 다음 결과를 집계하면 동일한 입력을 사용하기 때문에 모든 모델이 동일한 출력을 생성할 가능성이 높다는 것입니다.

Bootstrap 접근법은 이 문제를 해결하기 위해 Bagging에 의해 사용된다.

Boosting

Bagging에 있는 모델들은 서로 다릅니다. 우리는 더 나은 결과를 원한다면 추가된 새로운 모델이 이전 모델에서 발생한 실수를 바로잡을 수 있을 것으로 기대한다.

다시 말해, 기초 학습자들은 서로를 지원해야 합니다. 이게 부스팅의 중심입니다.

부스팅은 각각의 새로운 모델이 이전 모델의 실수를 수정하려는 반복적인 과정이다. 배깅은 병렬로 작동하며 부스팅은 순차적으로 작동합니다. 다음 모델은 이전 모델에 의존하지만, 백깅의 경우는 그렇지 않습니다.

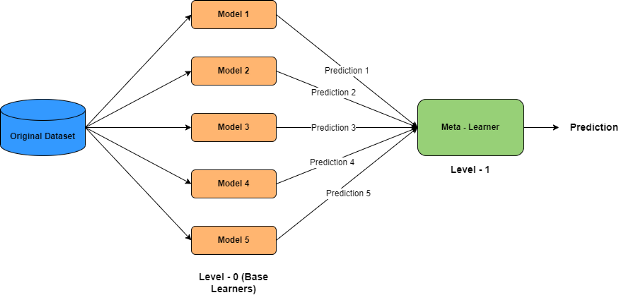

Stacking

스태킹에서, 우리는 훈련 데이터를 다른 모델을 통해 전달한다. 각 모형은 고유한 예측을 생성합니다. 그런 다음 이러한 예측은 최대 투표 또는 평균 대신 모형에 전송됩니다. 이러한 예측은 모델에 의한 입력으로 사용되어 최종 예측을 생성합니다. 스태킹은 이질적인 약한(heterogeneous weak) 학습자를 자주 고려하고 병렬로 학습한 다음 메타 학습자를 훈련시켜 약한 학습자의 예측을 기반으로 예측을 출력하는 반면, 배깅과 부스팅은 앙상블에 균일한 약한(homogeneous weak) 학습자를 고용한다.

스태킹 모델은 레벨 0 모델이라고도 알려진 둘 이상의 기본 모델과 레벨 1 모델이라고도 알려진 메타 모델을 포함하며, 기본 모델의 예측을 통합합니다. 예측의 종류에 따라 메타모형이 달라집니다. 로지스틱 회귀 모델은 분류에 사용되며 선형 회귀 기술은 회귀 메타 모델로 사용됩니다.

'ML(머신러닝)' 카테고리의 다른 글

| Transformer 간단하게 코드와 함께 살펴보기 (1) | 2023.06.09 |

|---|---|

| Python) 생존 분석 이해해보기 (KMF, LOG RANK TEST, CoxPH, AFT) (2) | 2023.02.21 |

| Python) AutoML 라이브러리 정리 (0) | 2023.02.08 |

| [Python] pycaret 패키지 (0) | 2020.08.30 |