좋은 논문인지는 모르겠지만, 일단 아이디어만 가져오기 위해서 빠르게 읽어 보려고 한다.

저자는 multi-action policies을 사용하면 single action selection기술을 사용할 때 달성하기 어려운 복잡한 행동을 학습할 수 있습니다.

거의 대부분의 강화학습들이 큰 action space에서 Single Action Per Time step(SAPS) policy로 복잡한 환경과 상호작용하면서 에이전트를 훈련을 시키고 있다.

예를 들어, 비디오 게임에서 스트라이핑 하고 촬영하는 동안 앞으로 달리는 것은 SAPS 아키텍처를 사용할 때 달성할 수 없는 전략이라고 한다.

그래서 보통 이러한 문제를 풀 때는 Multiple Action Per Time step(MAPS)가 필요로 하게 되는데, 대부분의 네트워크 아키텍처는 모든 가능한 조합들을 만들어서 SAPS로 만들어서 해결하고 있다.

그러나 이렇게 큰 액션 공간을 사용하면, 가능한 액션의 수가 기하급수적으로 커진다는 문제가 있다.

예를 들어 전형적인 게임에는 컨트롤할게 20개라면, $2^20$ 정도의 policy가 필요하게 될 것이다.

그래서 이런 joint action representation 은 실제 액션들의 각각의 가치를 학습하기가 어렵고, 각 액션들의 다른 셋을 사이에서 관계성을 기반으로 한 장점이 없어진다.

내가 여기 논문에서 관심을 가지고 있는 것은 MAPS지만 저자만 암튼 주장하는 것은 Multi-Action Per time step Limitation Learning( MAIL)에 기여한 점은 다음과 같다고 한다.

• We present a neural network architecture that outputs multiple discrete actions per time step (MAPS), as well as a loss function for training the multi-action policy.

• We describe a technique for training this algorithm using a combination of imitation learning and temporal difference reinforcement learning (MAIL).

• We describe how these techniques can be used to teach an agent to play a challenging fully 3D first person shooter (FPS) style video game, an important milestone on the way to training neural networks to play modern AAA FPS games.

Preliminaries

SAPS context

MAPS context

이런 관계에서 보면 $A_{sa} \in A_{ma}$라 할 수 있는데, 왜냐하면 SAPS 공간은 $A_{sa} = {a \in A_{ma}| \sum_i=1^N a_i =1}$

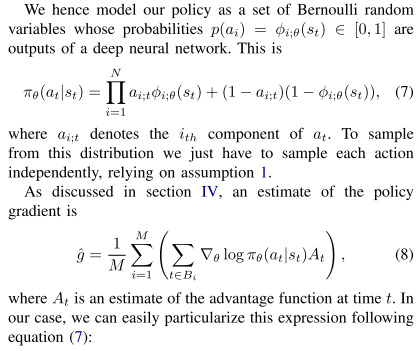

discrete multi action 설정에서 가능한 모든 이벤트 세트의 확률을 모델링하는 정책은 N이 커짐에 따라 다루기 어려워집니다. 이 문제를 회피하기 위해 본 논문에서는 정책에 대해 다음과 같은 구조적 가정한다.

$2^N$ 대신에 N개의 파라미터로 문제를 간단하게 만드는 가정이다, 즉 action 간에는 독립이다를 가정한 것이다.

사실 이 가정은 저자가 주장한 multi action과는 상반된 이야기지만, 저자는 single action 보다는 그래도 낫다고 말하는 것 같다.

실험

Environment

Action

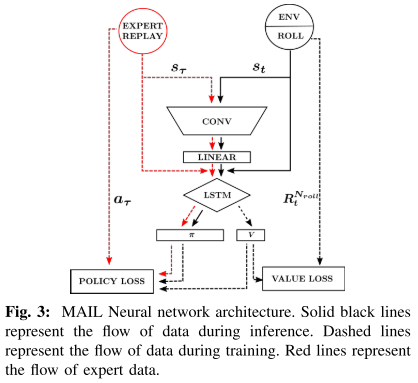

Network Architecture

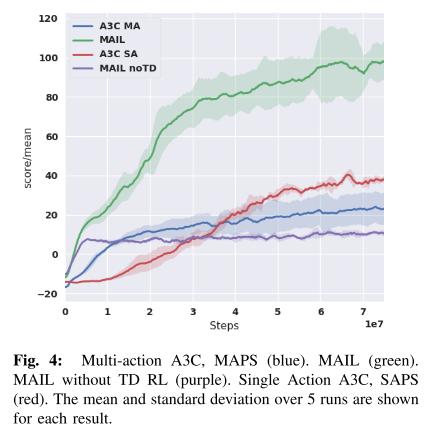

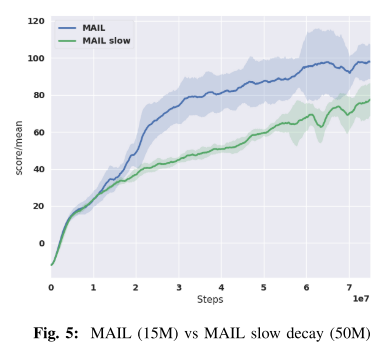

결과

나와 같은 고민을 하는 사람들이 있다는 것을 알게 되었고, 앞으로 더 자료 조사를 해봐야겠다!

Imitation Learning with Concurrent Actions in 3D Games

In this work we describe a novel deep reinforcement learning architecture that allows multiple actions to be selected at every time-step in an efficient manner. Multi-action policies allow complex behaviours to be learnt that would otherwise be hard to ach

arxiv.org

www.reddit.com/r/MLQuestions/comments/86ndn4/dqn_multi_action_is_possible/

DQN - Multi Action, is possible?

Hi! I’m studying RL by myself and I have a question buzzing in my head. Is it possible for a DQN to take multiple action a the same time? If yes...

www.reddit.com

'관심있는 주제 > RL' 카테고리의 다른 글

| [RL ENV] 강화학습 자동차 환경 (0) | 2021.01.05 |

|---|---|

| [Research] Action Space 관련 자료 조사 (0) | 2021.01.03 |

| [Review] POMO: Policy Optimization with Multiple Optimafor Reinforcement Learnin (0) | 2020.12.18 |

| [RL] 로봇 관련 시뮬레이터 URL (0) | 2020.12.02 |

| [Review] Hyp-RL : Hyperparameter Optimization by Reinforcement Learning (6) | 2020.11.28 |