What is Active Learning?

Active Learning is a technique in machine learning through which a learning algorithm specifically looks for the data which is most informative to the model instead being trained on whole dataset.

완전한 지도 학습 방법론에서는, 훈련하기 위한 모델을 위해서 많은 레이블을 가진 데이터를 필요로 한다.

그러나 만약 오직 unlabed만 가지고 있다면 어떻게 될까?

unlabeled dataset의 많은 풀에서 지도 기반 머신 러닝 알고리즘을 적용하기 위해서, 그 방법론은 모두 레이블이 필요로 한다. 이러한 경우에, 모든 데이터 객체에 레이블을 할 수 있는 사람 전문가를 가질 필요가 있다.

그러나 이 과정은 너무 비싸고, 시간이 많이 든다.

여기서 Active Learning이 구제 수단이다. 기본적인 생각은 우리가 훈련을 위해 몇 개의 데이터 샘플에 라벨을 붙이면서도 높은 정확도를 달성할 수 있다는 것이다. Active Learning은 사람 전문가에 의한 라벨링에 대해 라벨링되지 않은 몇 가지 구체적인 데이터 샘플을 선정할 것이라고 한다.

그리고 그 때 몇 개의 데이터 샘플들을 우리의 모델을 훈련시킬 것이다.

Active Learning은 라벨링 및 교육을 위해 전체 데이터 세트 대신 몇 개의 데이터 샘플만 선택했더라도 전체 데이터 세트에서 훈련된 모델과 유사하거나 더 높은 정확도/성능을 달성할 수 있음을 보장한다.

때때로, 이 과정은 반복적인 과정(iterative process)으로 구현되는데, 이것은 우리가 라벨이 부착되지 않은 샘플 풀에서 라벨을 반복해서 붙일 몇 개의 샘플을 선택한다는 것을 의미한다.

active learning은 semi-supervised learning은 간주한다. 완전 지도 학습 알고리즘은 훈련을 위해서 완전 레이블 데이터셋을 이용하다 반면에 비지도 학습 알고리즘은 오직 비 레이블 데이터로만 사용한다.

active learning 접근은 훈련을 위해서 데이터의 완전 데이터셋을 요구하지 않는다. 그러므로 semi supervised learning method로 불린다.

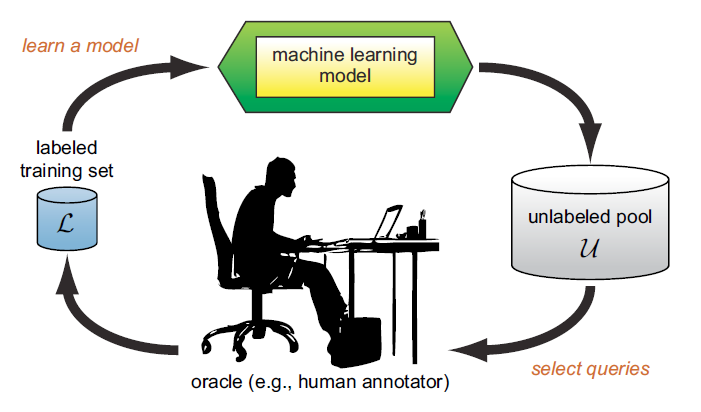

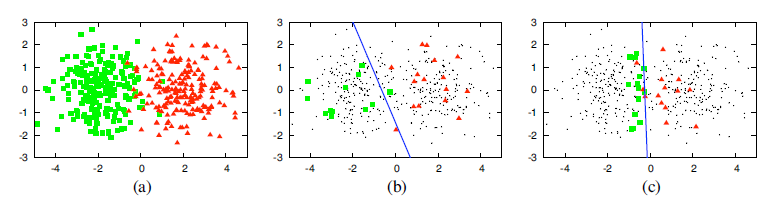

위의 사진은 pool-based active learning의 과정의 생생한 표현을 한 것이다. 여기서 인간 전문가는 "oracle"이라고 불린다. 이진 분류 예에서, 쉽게 왜 레이블을 위해서 몇개의 구체적인 데이터셋을 선택하는지 시각화할 수 있고 이해할 수 있다.

a는 large pool of unlabeled dataset를 표현한다. 지금 만약 우리가 훈련과 레이블링을 위해서 몇 개의 샘플들을 랜덤 하게 선택한다면, 그 알고리즘은 그림 b처럼 deicision boundary를 예측할 것이다.

여기서 만약 훈련과 레이블링을 위해서 데이터 샘플을 선택하는 active learning sampling 전략을 취한다면, active learning 알고리즘은 실제 decision boundar와 유사하게 선택될 것이다.

©에서 선택한 데이터 샘플은 두 개의 클래스를 분리하는 역할을 하므로 모델에서 학습할 수 있는 가장 유용한 데이터 샘플이다.

active learning 기술은 모델의 학습을 개선하고 모델의 차별성과 예측 능력을 향상시킬 수 있는 이러한 유형의 정보 데이터 샘플을 선택하는 것을 목표로 한다.

active learner를 위해서 3개의 다른 학습 시나리오가 있다.

1. Membership Query Synthesis

active learning algorithm은 인풋 스페이스와 레이블을 위해 orcale 쿼리로 새로운 레이블이 없는 객체를 생성할 수 있다.

2. Stream-based Selective Sampling

스트림 기반 선택적 샘플링에서는 라벨이 부착되지 않은 데이터 샘플이 데이터 소스에서 활성 학습자에게 지속적으로 전송되고 있다.

active learner는 질의 전략에 기초하여 오라클에게 현재 데이터 샘플에 라벨을 붙이도록 요청할 것인지 여부를 결정해야 한다. 데이터 소스에서 나오는 데이터의 분포는 시간이 지남에 따라 변할 수 있다.

3. Pool-based Sampling

이 시나리오에서, 데이터 샘플들은 레이블이 없는 데이터 샘플들의 풀로부터 오라클로써, 레이블링을 선택된다.

stream-based selective sampling과는 반대로 한 번에 하나의 데이터 샘플보다 초점을 맞출 수 있다.

스트림 기반의 선택적 샘플링과 대조적으로, 한 번에 두 개 이상의 데이터 샘플에 집중할 수 있다.

대부분 유용한 데이터 샘플들은 유용성 측도 또는 샘플링 전략들에 기반하여 레이블이 없는 데이터 샘플들의 풀로부터 선택된다.

active learning 알고리즘들을 위해 대부분 흔한 학습 상황이다.

우리는 actvie learning 알고리즘이 라벨링 되지 않은 데이터 집합의 풀에서 라벨링을 위한 몇 가지 specific데이터 샘플을 선택하는 것을 보았다. 그렇다면 이러한 "specific" 데이터 샘플은 무엇이며, 어떻게 선택할 것인가?

특정 데이터 샘플을 선택하는 과정은 우리가 지금 이해할 수 있는 active learning 샘플링 전략에 기초한다. active learning은 모델이 가장 많이 배울 수 있는 가장 유용하고 유용한 데이터 샘플을 선택하기 위해 특별히 고안된 이러한 샘플링 전략을 사용한다.

이러한 샘플링 전략은 다음과 같이 분류된다.

- Committee-based Strategies

- Large margin-based Strategies

- Posterior probability-based Strategies

Committee-based Strategies

committe-based strategies에서, 우리는 몇 가지 모델을 만들고 라벨에 표시될 가장 유용한 데이터 샘플을 결정하기 위해 이 모델들의 예측을 사용한다.

여기서 모델 세트를 committe라고 한다. 이 committe는 라벨이 부착되지 않은 특정 데이터 샘플에 대한 투표를 제공한다. 만약 우리가 committe에 n개의 다른 모델을 가지고 있다면, 우리는 하나의 데이터 샘플에 대해 n개의 예측을 할 수 있다. 데이터 샘플은 committe의 예측에 최대 이견이 있을 경우 가장 유용한 정보로 간주된다.

모델 committe에서의 의견 불일치는 아래 주어진 기능으로 측정할 수 있다.

- Entropy

- KL-Divergence

Entropy measure는 불확실성 샘플링의 부분이다. 불확도 샘플링에서 모형이 라벨링에 대해 충분히 확실하지 않거나 가장 확실하지 않은 경우 쿼리하기 위해 데이터 샘플을 고려한다.

식 위에서 $V(y_i)$는 특별한 레이블을 위해 투표의 수를 표현한다. $y_i$는 가능한 레이블들이다. 엔트로피는 다음 장에서 자세하게 설명되어진다. KL-Divergence는 다른 두 확률 분포 사이에서 거리를 표현한다.

이 전략 범주에서는 주로 사용되는 세 가지 방법을 많은 논문에서 취합하여 여기에 나타낸다. 몇몇의 앙상블 접근들은 committee의 construction을 위해서 사용된다. 이 방법들은 committee의 건설의 관점에서 다르다.

1. Query by Committee (QBC)

2. Entropy-based Query by Bagging (EQB)

3. Adaptive Maximum Disagreement (AMD)

Large margin-based Strategies

1. Margin Sampling (MS)

2. Multiclass Level Uncertainty (MCLU)

3. Margin Sampling-closest Support Vectors (MS-cSV)

Posterior probability-based Strategies

1. Least Confidence (LC)

2. Best-versus-Second-Best (BvSB) or Smallest Margin

3. Entropy

나중에 계속...

https://towardsdatascience.com/active-learning-sampling-strategies-f8d8ac7037c8

'관심있는 주제' 카테고리의 다른 글

| A Chat with Andrew on MLOps: From Model-centric to Data-centric A 간단 정리 (0) | 2021.03.29 |

|---|---|

| Paper) Out of Distribution Generalization in Machine Learning (0) | 2021.03.29 |

| Stock Movement Prediction from Tweets and Historical Prices - 리뷰 (0) | 2020.04.02 |

| 딥 러닝 BN / LN / WN의 정규화 설명 - 추천 자료 (0) | 2019.11.10 |

| Self Normalizing Neural Network (Fully Connected Layer 의 희망?) (0) | 2019.11.09 |