도움이 되셨다면, 광고 한번만 눌러주세요. 블로그 관리에 큰 힘이 됩니다 ^^

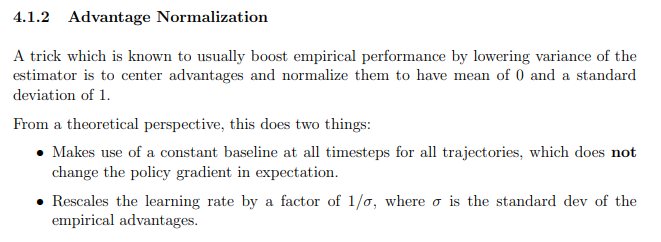

개인적으로 강화학습을 코드 볼 일이 있어서 보다가 표준화를 보게 되었다.

코드를 보다보니 Reward를 표준화하는 코드가 있어서 호기심이 들었다.

왜 Reward는 항상 양수로 되야 잘 되는거 아닌가 하면서 표준화를 하면 중심을 기준으로 어떤 것은 음수가 되고

어떤 것은 양수가 되면서 그만큼 Reward의 효과도 주는게 아닐까라고 생각을 했다.

그래서 찾아보니 몇가지 글이 있었다.

다른 분들도 참고하시길 바란다!

a2c REWARD 표준화하는 이유

http://www.modulabs.co.kr/RL_library/4225

OpenRL - 강화학습 그리고 OpenAI - 4: CartPole with Policy Gradient (2) Code Review

2016.07.20 Leewoongwon Reinforcement Learning 그리고 OpenAI 1. Introduction to OpenAI 2-1. Intro to Reinforcement Learning (1) MDP & Value Function 2-2. Intro to Reinforcement Learning (2) Q Learning 3-1. CartPole with Deep Q Learning (1) C

www.modulabs.co.kr

Normalizing Rewards to Generate Returns in reinforcement learning

The question is about vanilla, non-batched reinforcement learning. Basically what is defined here in Sutton's book. My model trains, (woohoo!) though there is an element that confuses me. Backgrou...

stackoverflow.com

http://rail.eecs.berkeley.edu/deeprlcourse-fa17/f17docs/hw2_final.pdf

A2C 코드 (PYTorch)

https://github.com/rgilman33/simple-A2C/blob/master/2_A2C-nstep.ipynb

rgilman33/simple-A2C

A simple A2C made from scratch in PyTorch. Accompanying comic at https://hackernoon.com/intuitive-rl-intro-to-advantage-actor-critic-a2c-4ff545978752 - rgilman33/simple-A2C

github.com

A2C (Tensorflow)

http://steven-anker.nl/blog/?p=184

More A2C in Tensorflow – Steven's Blog

I started writing this post a long time ago, but never got to the point of finishing and publishing it. Since A3C and A2C still seem to be relevant I’ve decided to wrap it up and publish it. Introduction Ever since Deepmind’s publication on playing Atari

steven-anker.nl

'관심있는 주제 > RL' 카테고리의 다른 글

| chapter 4 Dynamic Programming Example Grid World (0) | 2020.05.05 |

|---|---|

| 강화학습 - Dynamic Programming 공부 (0) | 2020.05.01 |

| state value / state action value 관련 자료 (0) | 2020.04.27 |

| Contextual Bandits and Reinforcement Learning - 리뷰 (0) | 2020.02.18 |

| Using Deep Q-Learning in the Classification of an Imbalanced Dataset - 리뷰 (0) | 2020.01.07 |