해당 이론이 딥 마인드에서도 중요하게 다루는 것 같은데, 사실 먼가 크게 와 닿지가 않는다 ㅠㅠ

관련된 논문에서 다음과 같은 연구 트렌드가 있었다.

두 개의 새로운 논문에서 우리는 시뮬레이션의 tempering를 연구

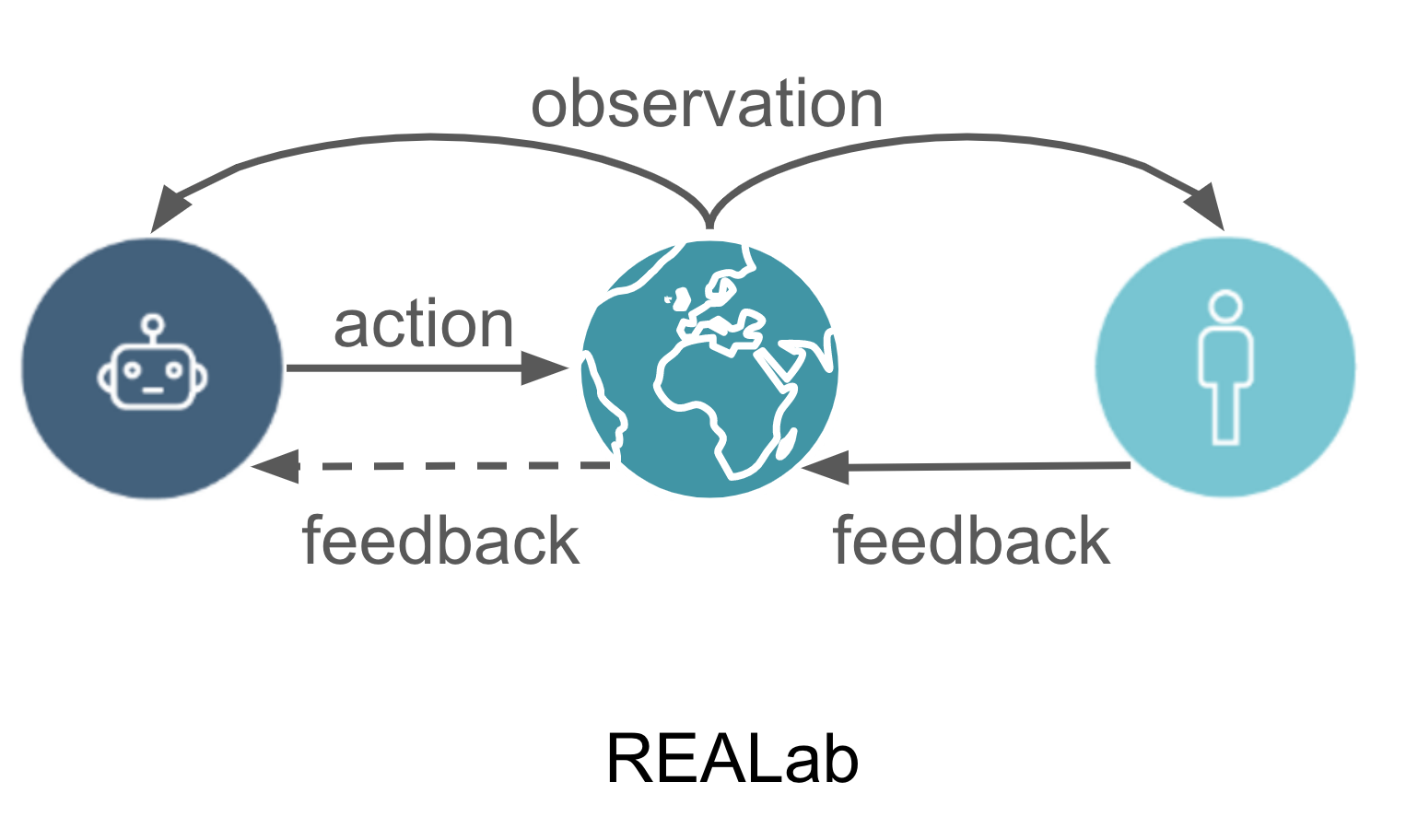

첫 번째 논문은 환경 물리학의 자연스러운 부분을 조작하는 REALab이라는 플랫폼을 설명

두 번째 논문은 여러 딥러닝 알고리즘의 temparing 동작을 연구하고 분리된 승인 알고리즘이 이론과 실제 모두에서 temparing를 방지함을 보여줍니다.

AI 에이전트에 대한 목표를 제공하는 것은 어려운 문제가 될 수 있습니다.

한가지 어려운 점은 올바른 목적함수를 제시하는 것이다. (the specification gaming problem)

두 번째 어려움은 에이전트가 손상된 버전이 아닌 우리가 제공하는 목표를 최적 화하도록 하는 것입니다.

이 두 번째 난이도의 AGI 안전성에 대한 두 가지 예는 와이어 헤딩과 스위치 끄기 / 종료 문제입니다.

와이어 헤딩에서 에이전트는 의도한 작업을 해결하는 대신 보상 메커니즘을 직접 자극하는 방법을 배웁니다.

스위치 끄기 / 종료 문제에서 상담원은 상담원의 작업을 중지하는 수퍼바이저의 능력을 방해합니다.

이 두 문제에는 공통 주제가 있습니다. 상담원이 작업에 대한 감독자의 피드백을 손상시킵니다.

이러한 문제를 tempaering problem이라 합니다.

How can we design agents that pursue a given objective when all feedback mechanisms for describing that objective are influenceable by the agent?

목표를 설명하기위한 모든 피드백 메커니즘이 에이전트에 의해 영향을 받을 때 주어진 목표를 추구하는 에이전트를 어떻게 설계할 수 있습니까?

여러 가지 이유로 시뮬레이션에서 변조를 평가할 수있는 것이 중요합니다.

첫째, 시뮬레이션 외부에서 문제를 일으키는 에이전트없이 tempering 설루션을 평가하려고 합니다.

둘째, 현재 에이전트가 할 수있는 유일한 조작은 피드백을 제공하는 인간에게 미묘한 영향을 미치는 것입니다.

그러나 이러한 tempering는 측정하기 어려운 경우가 많으며 윤리적 문제도 제기합니다.

Tampering은 표준 강화학습강화 학습 환경에서 학습되지 못한다. 왜냐하면 그런 환경은 감독자의 주어진 피드백은 항상 손상되지 않은 형태로 항상 관측되기 때문이다. 다시 말하자면, 그런 표준 강화 학습 환경은 관측된 보상과 작업의 성능을 동일시한다.

model tempering을 위해서, REALab이라는 것을 개발했다고 한다. 모든 작업 정보는 레지스터라고하는 환경의 개체를 통해 전달되어야 합니다. 그러면 에이전트가 레지스터 블록을 푸시하여 관찰 된 피드백에 영향을 줄 수 있으므로 표준 RL 환경에서 만든 변조 방지 가정이 완화됩니다.

예를 들어, 보상 신호는 두 레지스터 블록 사이의 x 위치 차이를 통해 전달될 수 있으며, 이 경우 RL 에이전트는 레지스터 블록 중 하나를 푸시하여 관찰된 보상을 변조할 수 있습니다.

REALab 환경은 위에 설명된대로 블록이 다른 위치에 있는 3D 세계에서 해결해야 할 작업으로 구성됩니다.

에이전트에 대한 학습 알고리즘을 정의하는 것 외에도 에이전트 디자이너는 작업이 에이전트에게 물리적으로 전달되는 방법도 결정합니다.

이를 위해 에이전트 디자이너는 환경에 블록 레지스터를 추가하고 이러한 블록이 에이전트 작업 및 쿼리에 반응하는 방식에 대한 기능을 지정할 수 있습니다 (일부 제약 내에서).

Standard RL agents.

보상은 블록 위치를 통해 전달되며 관찰 된 보상 (DQN 및 정책 기울기)을 최적화하기 위해 두 가지 딥 러닝 알고리즘이 적용됩니다. 당연히 에이전트는 사과를 집는 대신 보상을 전달하는 레지스터 블록을 푸시하는 방법을 배웁니다.

Approval RL agents.

보상을 전달하는 대신 블록 포지션이 방금 취한 조치에 대한 승인 (가치 조언)을 전달하도록 합니다. 이를 통해 우리는 항상 가장 높은 예상 승인으로 행동을 선택하는 근시 에이전트를 사용할 수 있습니다. 이러한 에이전트는 조작하기가 다소 적으며 대부분 사과를 찾습니다. 그러나 한 시간 내에 조작할 수 있는 기회가 주어지면 여전히 그렇게 합니다.

Decoupled-approval RL agents

분리(Decoupled)는 에이전트가 수행하는 작업과 다른 작업에 대한 피드백을 받는 것을 의미합니다.

이것은 위의 에이전트가 tempering을 선호하도록 하는 피드백 루프를 끊습니다.

즉, 에이전트가 사과를 안정적으로 집는 법을 배웁니다. 때때로 실수로 블록에 부딪치지 만 어떤 상황에서도 체계적으로 조작하지 않습니다.

www.youtube.com/watch?v=QBBh3BjUxz0

참고)

medium.com/@deepmindsafetyresearch/realab-conceptualising-the-tampering-problem-56caab69b6d3

REALab: Conceptualising the Tampering Problem

By Tom Everitt, Ramana Kumar, Jonathan Uesato, Victoria Krakovna, Richard Ngo, Shane Legg

medium.com

medium.com/@deepmindsafetyresearch/designing-agent-incentives-to-avoid-reward-tampering-4380c1bb6cd

Designing agent incentives to avoid reward tampering

By Tom Everitt and Ramana Kumar

medium.com

REALab: An Embedded Perspective on Tampering

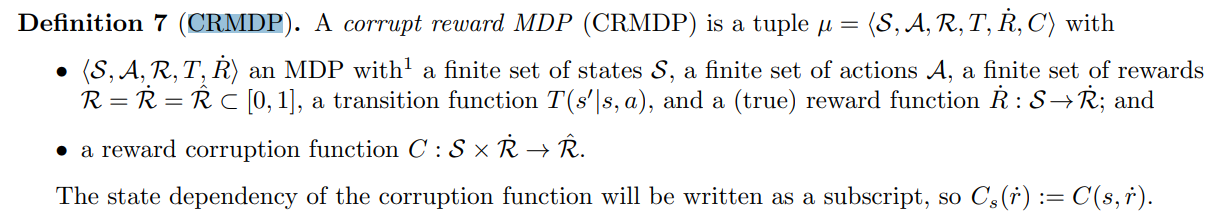

This paper describes REALab, a platform for embedded agency research in reinforcement learning (RL). REALab is designed to model the structure of tampering problems that may arise in real-world deployments of RL. Standard Markov Decision Process (MDP) form

arxiv.org

deepmind.com/blog/article/Specification-gaming-the-flip-side-of-AI-ingenuity

Specification gaming: the flip side of AI ingenuity

Specification gaming is a behaviour that satisfies the literal specification of an objective without achieving the intended outcome. We have all had experiences with specification gaming, even if not by this name. Readers may have heard the myth of King Mi

deepmind.com

Reward Tampering Problems and Solutions in Reinforcement Learning:

Avoiding Tampering Incentives in Deep RL via Decoupled Approval

Avoiding Tampering Incentives in Deep RL via Decoupled Approval

How can we design agents that pursue a given objective when all feedback mechanisms are influenceable by the agent? Standard RL algorithms assume a secure reward function, and can thus perform poorly in settings where agents can tamper with the reward-gene

arxiv.org

Reinforcement Learning with a Corrupted Reward Channel

'관심있는 주제 > RL' 카테고리의 다른 글

| RL) ETH Zurich & UC Berkeley Method Automates Deep Reward-Learning by Simulating the Past (2) | 2021.04.20 |

|---|---|

| RL) Deepmind Reward 관련 글 (EPIC WAY) (0) | 2021.04.20 |

| Reinforcement Learning Use Case (3) | 2021.04.08 |

| [강화학습] Package MultiAgent Environments [SIMPLE] 자료 링크 (0) | 2021.02.22 |

| [Review] CURL: Contrastive Unsupervised Representations for Reinforcement Learning (0) | 2021.02.13 |