2017년에 DeepMind에서 작성한 논문

대부분의 딥강화학습은 많은 시나리오에서, 그들의 적용 가능성이 제한되고, 복잡한 환경에 대해서 데이터 비효율적입니다.

데이터 효율성을 개선하기위한 한 가지 방향은 공유된 신경망 매개 변수를 사용한 멀티 태스킹 학습이며, 여기서 관련 작업 간의 전송을 통해 효율성을 개선 할 수 있습니다.

그러나 실제로는 일반적으로 관찰되지 않습니다. 다른 작업의 기울기가 부정적으로 간섭하여 학습을 불안정하게 만들고 때로는 데이터 효율성이 떨어질 수 있기 때문입니다.

또 다른 문제는 테스크간에 서로 다른 보상 체계가 있다는 것인데, 이는 공유 모델의 학습을 지배하는 한 테스크로 쉽게 이어질 수 있습니다.

그래서 딥마인드는 다중 테스크들의 조인트 트레이닝에 관한 새로운 접근을 제안한다고 합니다.(Distral : distill & transfer learning)

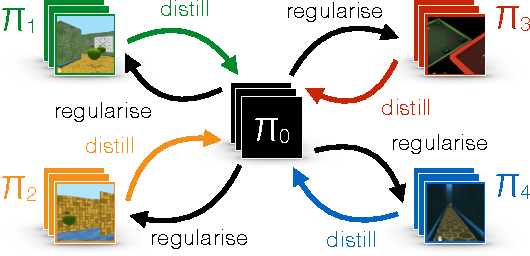

서로 다른 작업자간에 매개 변수를 공유하는 대신 작업 전반에 걸쳐 공통된 행동을 포착하는 "증류 된"정책을 공유 할 것을 제안합니다.

각 작업자는 자신의 작업을 해결하도록 훈련 받으면서 공유 정책에 가깝게 유지하도록 제한하는 반면, 공유 정책은 모든 작업 정책의 중심이되도록 증류에 의해 훈련됩니다.

학습 과정의 두 측면 모두 공동 목적 함수를 최적화하여 파생됩니다.

접근 방식은 복잡한 3D 환경에서 효율적인 전송을 지원하여 여러 관련 방법을 능가한다고 합니다.

또한 제안된 학습 프로세스는 초 매개 변수 설정에 대해 더 강력하고 더 안정적입니다.

이는 심층 강화 학습에 중요한 속성이라고 저자는 말합니다.

아래 내용은 시간이 없는 관계로 깊지 않게 다뤘습니다. 추후에 여력이 될 때 다시 한 번 보고 정리를 하겠습니다

시간이 없어서 아주 대충 훑어 봤지만, 결국에 역시 Constraint이 나오니 KL Divergence 이야기 나옵니다.

$\pi_0$ 라는 distilled policy가 있고 여러 task들에서 나오는 $\pi_i$ 들이 있는데,

아래 공식에서 이 차이가 커지지 않게 하는 제한 조건이 추가된 것을 알 수 있습니다.

맨 뒤에 있는 entropy term 같은 경우 exploration은 권장하는 loss로써, 제한을 걸지만, 더 많은 탐험을 하라는 의미라고 합니다.

distilled policy를 가지고 의미를 부여하는 내용들이 나옵니다.

저자는 이것을 Soft Q Learning 에서도 사용하고, Policy Gradient 계열에서도 사용할 수 있다는 내용도 나옵니다.

실험 결과

'관심있는 주제 > RL' 카테고리의 다른 글

| [Review] Hyp-RL : Hyperparameter Optimization by Reinforcement Learning (6) | 2020.11.28 |

|---|---|

| [RL] 강화학습 알고리즘 baseline 코드 URL (0) | 2020.11.27 |

| [Survey / RL] Action Masking 관련 자료 (0) | 2020.10.24 |

| [Review / RL ] Deep Reinforcement Learning in Large Discrete Action Spaces (0) | 2020.10.24 |

| RL multiple action space일 경우 단순 고민... (0) | 2020.10.24 |