SuperTML: Two-Dimensional Word Embedding for the Precognition on Structured Tabular Data

"Super Characters: A Conversion from Sentiment Classification to Image Classification"를 모티브로 한 논문이다.

해당 논문은 글자를 이미지를 이용해서 분류하는 방법론을 정형데이터도 이미지로 만들어서 적용하였다.

실제로 이러한 방법론이 됬으면 좋겠다고 생각은 하고 있었으나, 필자는 그 숫자 값을 3차원으로 표현해서 시도를 했었고, 이 저자는 숫자들을 이미지화해서 하니 잘된 것을 보였다. 그래서 정형 데이터에 이러한 시도를 한 것이 너무나 반갑다.

제안된 SuperTML 방법은 숫자 값으로 전처리 할 필요 없이 표 형식 데이터의 범주형 데이터와 결측 값을 자동으로 처리

위의 문장이 아주 충격적이라서 더 관심을 가지게 되었다.

정형 데이터를 분석하기 위해서는 feature engineering이 너무나도 중요하고 많은 시간을 할애하는데, 저 논문에서는 마치 이미지에서 전처리 조금 하듯이 거의 전처리를 디테일하게 할 필요 없이 넣기만 하면 잘된다라고 주장하는 것이다.

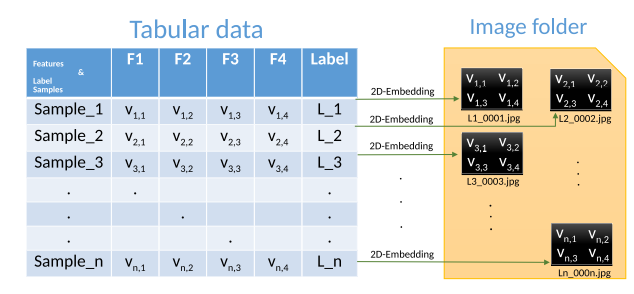

저자는 분류 문제를 풀기 위해서 1차원으로 2차원으로 투영하는 방식을 선택했다. 그리고 여기서 그냥 CNN을 구성하는게 아니라 이미 학습된 resnet이나 denset 같은 것도 사용할 수 있다. 즉 이 말은 pretrained model을 사용하여, 보다 빠른 학습을 가능하게 할 수 있다는 것으로 들려서, 더 특별하다고 느껴졌다.

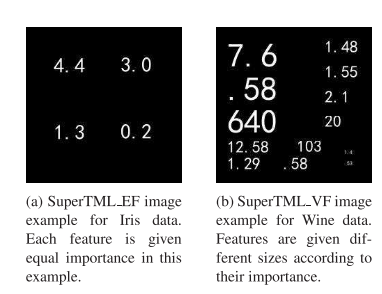

그리고 저자는 데이터를 이미지화하는데서 크게 2가지를 제안하고 있다.

1. SuperTML_VF(Variant Font)

변수 중요도에 따라서 정형데이터를 이미지화할 때 크기를 다양하게 구성하는 것이다.

2. SuperTML_EF(Equal Font)

변수 중요도를 고려하지 않고, 이미지화할 때 동일하게 구성하는 것이다.

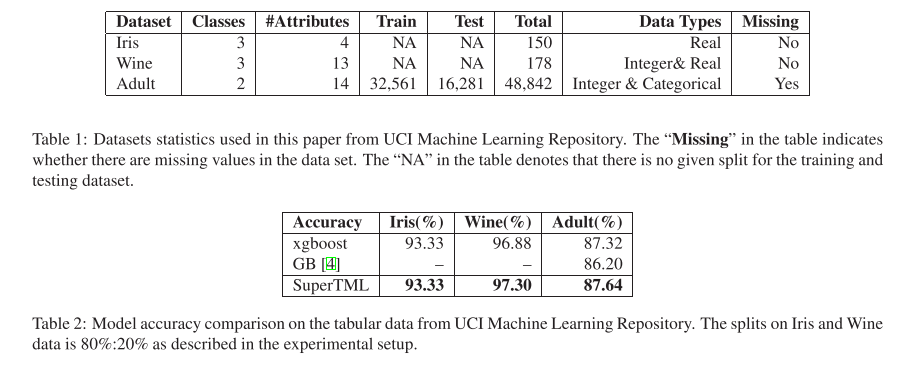

실험

사실 실험을 이것밖에 안해본 것은 굉장히 아쉽다...

뭔가 더 어려운 문제에 대해서 적용해봤으면 하는데, 그런 실험들은 하지 않았다.

아마 성능이 안나와서 빼지 않았을까 싶기도 하다.

예를 들어 unbalanced dataset이나 결측이 많거나 이런 것을 해보지 않아 아쉽다.

그리고 또 하나 주장하는 것은 자기 논문은 작은 데이터셋을 사용해도 오버피팅이 안된다고 하는 점이다.

어떻게 보면, 이것은 데이터셋에 민감하지 않다는 말일 수도 있다고 생각은 한다.

예를 들어, 연속형 변수가 하나씩 움직일 때마다 정말 중요한 역할을 할 수 있는데, 이미지화 하다보면 이러한 부분이 실제로 반영되디가 어렵기 때문에 그런 점이 고려가 안되서 오버피팅이 더 안된지 않는게 아닐까라는 생각도..(사견).

결론

저자는 IoT 환경이나 이런 것들에서 현재 Logistic Regression 방법론을 사용하니, 자기 논문을 사용하면 유용하다고 말하고 있다. 사실 특정 도메인에서 잘된다라는 말은 잘 모르겠지만, 정형 데이터에서 새롭게 시도해볼 만하다고 생각한다.

차후에 진행할 것은 다음과 같다고 한다.

첫째, 텍스트 분류, 범주형 데이터 및 결측값 계산에서 Super Characters 방법 [33, 32]의 성공을 감안할 때 SuperTML 방법은 해당 분야의 현재 모델을 직접 보완하거나 대체할 수 있어야 한다고 한다.

왜냐하면 숫자형 변수와는 달리 범주 기능에는 텍스트에 기록 된 모든 정보가 있기 때문에 특징을 잘 잡을 수 있을 것이다라고 말하는 것 같다.

둘째, Gradient Boosting 방법뿐만 아니라 1 차원 임베딩 기반 RNN 및 CNN 방법과 비교하여 SuperTML은 TML 작업을 계산하고 해결하는 데 있어 새로운 최첨단이 될 수 있습니다.(이것은 더 고도화가 된다면 동의)

셋째, SuperTML 방법은 NASNet, PNASnet 등과 같은보다 강력한 CNN을 지원하기 위해 확장될 수 있습니다.

넷째, 모델 아키텍처를 수정하고 개선함으로써 어텐션 [3, 36] 체계를 구현하는보다 정확한 방법을 찾기 위해 변형 기능 중요도 계산을 개선할 수 있다고 한다.

요즘 최신 논문에서 이미지를 Transformer로 하는 논문이 있었다.

정형 데이터 -> 이미지 -> transformer로 사용하는 방안도 정말 괜찮다고 생각이 들었던 논문이였다.

Pros

• Simple Idea that is easy to use and manipulate

• No data normalization, no categorical features special treatmen no costly fine-tuning via grid search

• Get advantage of the best CNN classifiers

• No overfitting on small datasets

Cons:

• Make sure the features on an image do not overlap

• Numerical values have some hidden relationship behind the shape of the digits, such as 6.01 and 5.999 (did stop us so far!)

SuperTML: Two-Dimensional Word Embedding for the Precognition on Structured Tabular Data

Tabular data is the most commonly used form of data in industry. Gradient Boosting Trees, Support Vector Machine, Random Forest, and Logistic Regression are typically used for classification tasks on tabular data. DNN models using categorical embeddings ar

arxiv.org

Modelling tabular data with Neural Networks and Transfer Learning! How and Why?

How we can fine-tuned a classifier of natural images to perform machine learning tasks for tabular data?

towardsdatascience.com

비슷한 논문

www.biorxiv.org/content/10.1101/2020.05.02.074203v1.full

'관심있는 주제 > 뉴럴넷 질문' 카테고리의 다른 글

| Causual Inference 관련 자료 모으기 (1) | 2020.10.26 |

|---|---|

| [Review / NN] Cyclical Learning Rates for Training Neural Networks 논문 (0) | 2020.10.21 |

| Generative Teaching Networks: Accelerating Neural Architecture Search by Learning to Generate Synthetic Training Data - 리뷰 (0) | 2020.03.21 |

| Graph Neural Networks 이란? (파파고 번역) (3) | 2020.02.16 |

| Ensemble Neural Network Architectures (0) | 2020.01.25 |