nni(neural network intelligence)라는 microsoft에서 만든 오픈 소스가 있다. 이 오픈 소스는 자동 머신 러닝을 지원하고 있다.

확인을 하던 도중 변수 선택 방법에서 Feature Gradient라는 방법이 있었다.

기존에 잘 알지 못했던 방법이기도 하고, 실제로 들어가 있으니 좋은 방법일거라고 생각해서 논문을 읽어보기로 했다.

실제 구현 코드도 내부에 있어서 괜찮다 싶으면 더 자세히 파야겠다.

본 논문에서는 Feature Gradents 라고 하는 변수 선택을 위한 gradient based search algorithm을 제안한다.

해당 알고리즘은 combinational optimization 문제로써 변수 선택을 다루고, 효율적으로 가능한 변수 셋들의 공간을 탐험하기 위해 discrete relaxation을 배치했다고 한다.

(? discrete relaxation은 무엇일지?)

크게 3가지를 제안하고 있다.

- 낮은 계산 복잡도

- 높은 통계적인 효율성

- 고차 교호작용의 효율적인 검출

Feature Gradients

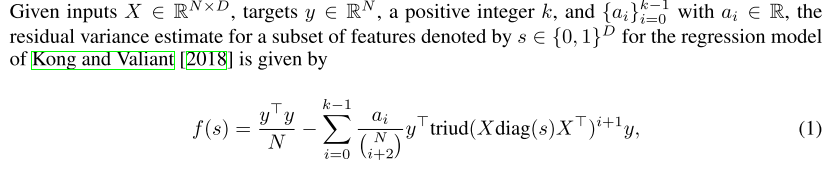

우리의 알고리즘은 Kong과 Valiant[2018]에 의한 선형 모형의 학습 가능성에 관한 최근의 연구에 기초하고 있는데, 이 연구는 고차원 회귀(잔차 분산)와 분류(정확성)에서 선형 예측자의 성능에 대한 높은 확률 한계를 제공한다. 특히 그들이 도입한 추정기의 한계는 차원에 대한 하위 선형 의존성을 가지고 있어 데이터가 상대적으로 적은 태스크의 데이터 집합에 어떤 기능 부분집합이 가장 유용했는지 잘 알고 있는 의사결정의 가능성을 강조한다. 우리는 이러한 추정기에 대한 간략한 설명을 시작으로, 연속적인 공간에 걸쳐 최적화를 통해 형상 선택에 어떻게 수정 및 활용될 수 있는지를 보여 준다. 설명의 명확성을 위해, 우리는 회귀 사례에 초점을 맞추지만, 동일한 아이디어와 접근방식은 분류에 대해 보류한다.

triud는 lower triangular 부분과 diagonal 부분이 0?인것이라고 한다.

변수들 간에 iid을 가정한다고 한다.

읽다가 포기;; 머라는 지 모르겠다. 그냥 실험한 거나 보자

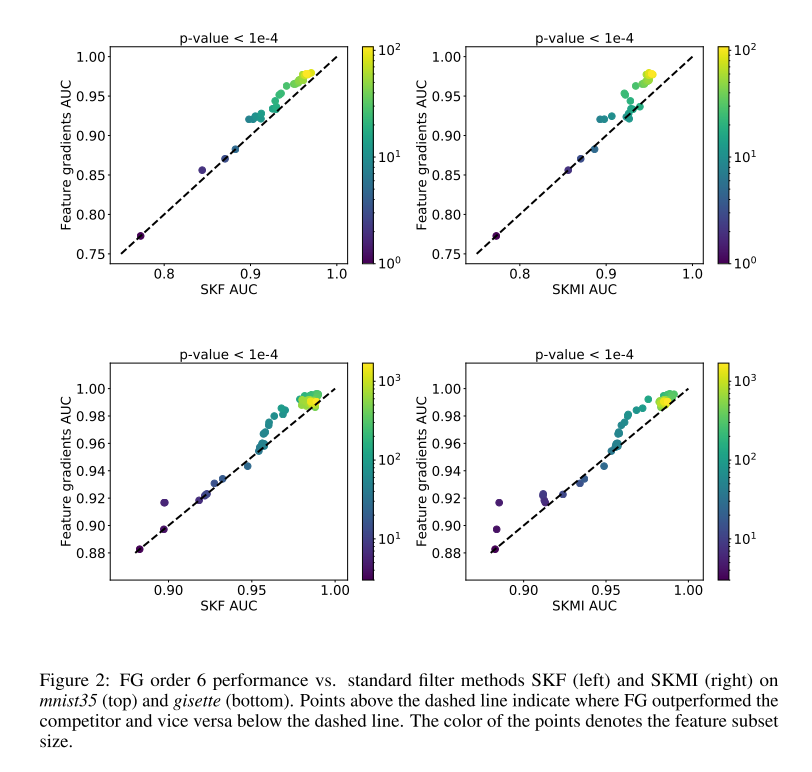

위의 그림을 봤을 때 SKF, SKMI가 기존 변수 선택 방법인데, 성능 향상을 한 것을 확인했다고 함.

음... 암튼 먼가 그냥 개인적인 생각으로 이거 구현할 시간에 다른걸 해봐야겠다.

망한 리뷰 끝

'관심있는 주제 > 분석 고려 사항' 카테고리의 다른 글

| GAIN CHART와 LIFT CHART 이해하기 (0) | 2022.08.04 |

|---|---|

| KS(Kolmogorov-Smirnov Statistics) 통계량 알아보기 (0) | 2022.07.30 |

| Pytorch vs Tensorflow 비교 (3) | 2020.03.05 |

| Tricks for Manipulating Probability - 리뷰 (0) | 2019.12.28 |

| Knowledge is Everything: Using Representation Learning to Optimize Feature Extraction and Knowledge Quality - 리뷰 (2) | 2019.12.28 |