눈 딱감고 한번만 광고 눌러주세요!

|

https://towardsdatascience.com/understanding-dataset-shift-f2a5a262a766 Dataset Shift에 대한 이해 (1) - Covariate Shift Dataset Shift에 대한 이해 (2) - Prior probability Shift, Concept Drift |

Internal Covariate Shift

이러한 토픽에 대해서 관심을 가지게 된 이유는 딥러닝 네트워크에 히든 레이어들의 공변량 변화를 의심되는 영향 때문이다. 연구자들은 후속 계층에 대한 입력으로 사용되는 특정 숨겨진 계층의 출력에 의한 활성 분포의 변화 때문에, 네트워크 계층은 깊은 신경 네트워크의 훈련을 방해할 수 있는 공변량 이동에 시달릴 수 있다는 것을 발견했다.

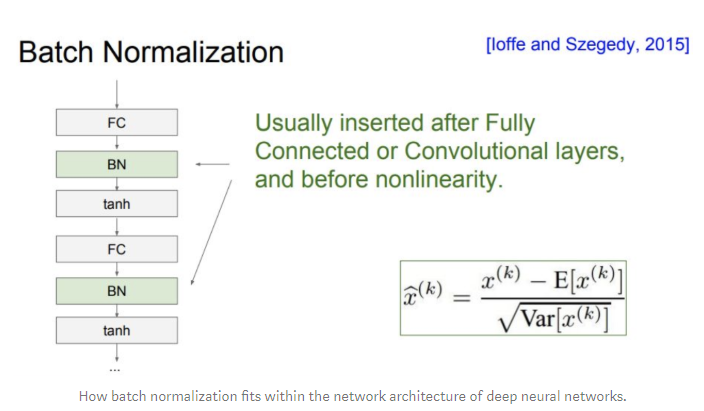

This idea is the stimulus of batch normalization, proposed by Christian Szegedy and Sergey Ioffe in their 2015 paper “Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift”.

저자들은 히든 레이어들의 내부 공변량 변화가 훈련을 늦추고 낮은 학습률과 신중한 매개변수 초기화를 요구한다고 제안한다. 저자들은 batch normalization layer를 더함으로써, 히든 레이어들에 대한 입력을 정상화함으로써 이 문제를 해결한다.

batch norm layer는 샘플 배치의 평균과 표준 편차을 취한다. 그리고 인풋의 표준화를 위해서 batch norm을 사용한다.

또한 network의 정규화를 돕기위해서 인풋에서 몇몇의 노이즈를 더한다. (왜냐하면 다른 배치들 사이에 평균과 표준편차 내재된 잡음을 영향을 받았다)

Batch Normalization

이 문제는 다양한 분포를 학습의 안정화를 돕는 보다 안정적인 내부 데이터 분포(덜 표류/수축)로 변환하는 역할을 한다.

배치 정상화는 현재 심층 학습 커뮤니티에서 잘 채택되고 있지만, 최근의 논문은 이 기법으로 얻은 개선된 결과가 단순히 내부 공변량 이동의 억제 때문은 아닐 수 있으며, 대신에 네트워크의 손실 지형을 평탄하게 한 결과일 수 있다고 언급했다.

배치 정상화, 그 목적, 그리고 그 구현에 익숙하지 않은 사람들을 위해, 나는 앤드류 Ng의 관련 유튜브 비디오를 볼 것을 추천한다. 그중 하나는 아래에 연결되어 있다.

Major Causes of Dataset Shift

데이터 세트 이동의 가장 일반적인 두 가지 원인은 (1) 표본 선택 편향(Sample selection bias) 과 (2) 비정상 과정 환경들(non-stationary environments)이다.

이러한 유형의 데이터셋 전환이 아니며, 항상 dataset shfit가 항생 발생하는 것은 아니라는 점을 유념해야 한다.

그것들은 단지 우리 데이터에서 dataset shift에서 발생하는 잠재적인 이유 둘이다.

Sample selection bias

분포의 불일치는 편향된 방법을 통해 얻은 훈련 데이터 때문이다. 그러므로 분류기가 배포될 운영 환경(기계 학습 용어로 시험 세트를 구성함)을 신뢰성 있게 나타내지 않게 된다

Non -stationary environments

training 환경과 test 환경이 다를 때, 그것은 시간적이거나 공간적인 이유로 인해 발생한다.

Sample Selection Bias

Sample selection bias는 알고리즘이나 데이터 취급에 결함이 아니다.

그것은 순전히 데이터 수집이나 라벨링 과정의 시스템적인 결함이다.

이것은 모집단의 훈련 샘플의 선택이 불균일하게 선택되어 학습 동안 편견이 형성되는 원인일 수도 있다.

Sample selection bias는 데이터 분포에 영향을 미치기 때문에 covariance shift의 한 형태라고 할 수 있다.

모델이 그것의 인위적인 학습 환경이거나 cherry-picked 된 운영환경으로 최적화하도록 운영환경을 잘못 표현한 것이라고 간주할 수 있다.

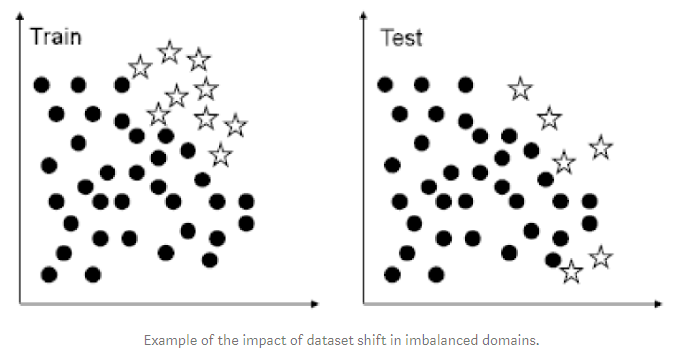

sample selection bias에 따른 Dataset Shift는 특히 분균형 분류 문제를 다루는 것과 관련되어 있다.

왜냐하면, 매우 불균형이 된 도메인들에서, 그것을 나타내는 적은 클래스의 샘플 때문에 소수 class는 특히 두드러진 분류 오류에 민감하기 때문이다.

극단적인 경우, 소수 class의 잘못 분류된 오분류된 단일 예는 성능에 주요한 하락을 만들었다.

Non -stationary environments

실제 애플리케이션에서는 데이터가 정지해 있지 않은 경우가 많다.

가장 관련성이 있는 비정상 과정 시나리오 중 하나는 스팸 필터링 및 네트워크 침입 탐지 등과 같은 상대적 분류 문제를 포함한다.

이러한 유형의 문제는 기계 학습 분야에서 점점 더 많은 관심을 받고 있으며, 기존 분류기의 학습된 개념을 중심으로 작업하려는 적대자의 존재로 인해 대개 비정상 과정 환경에 대처한다.

머신러닝 테스트 관점에서 이 적수는 테스트 세트를 훈련 세트와 달라지도록 워밍업 하여, In terms of the machine learning task, this adversary warps the test set so that it becomes different from the training set, thus introducing any possible kind of dataset shift.