사실 머라고 하는지 잘 모르겠다ㅎㅎ

코드는 공개가 되어있지만, 논문에 나온 mnist로 한 것은 없다보니,,, 일단 딥마인드가 했다길래, 빠르게 보려고 했는데, 딱히 나와는 큰 상관이 없어보여서 일단 왠지 큰 느낌은 실제 데이터를 직접적으로 비교하기보단, 어떤 F라는 연산을 통해 낮은 차원으로 보내서 거기서 비교하는 간접적인 계산으로 한다는 것 같긴한데........흐음 ( 아닐 수도 있고...)

대충 봐도 딱 느낌이 안와서 일단 패스

| https://paperswithcode.com/paper/deep-generative-adversarial-networks-for#code | https://arxiv.org/abs/1905.06723 |

제한된 임의 측정을 통해 이미지를 복구하고 자연스러운 이미지의 구조를 개척하는 Compressed Sensing 능력은 압축 된 측정에서 희소한 신호를 복구할 수 있는 훌륭한 프레임워크가 되었습니다.

비록 CS는 유연하고 , 데이터 효율적이지만, Sparsity의 강한 가정과 값비싼 복원 절체로 제한이 되었습니다.

이 논문에선 이러한 문제를 Neural Network 생성자와 결합해서 Sparsity의 대한 제한을 해결했지만, 아직 복원 문제는 해결 못했다고 합니다.

그래서 딥마인드의 몇몇 연구자들이 신호 복원 성능과 속도를 유의미하게 향상시킬 것을 소개했다고 하네요.

공동으로 생성자를 훈련하는 것과 메타 러닝에 의해서 복원을 위한 최적화 과정을 포함한다고 합니다.

연구원은 다양한 목표로 측정을 교육하고 모델 중 "특수 사례"로 간주되는 생성 적 적자 네트워크 (GAN)를 사용하여 측정 오류를 최소화하기위한 일련의 모델을 얻었습니다.

연구자들은 CS 관점으로부터 이전의 통찰력을 기반한 Discriminator로 부터 Gradient Information을 사용한 GAN을 향상시키는 참신한 방법으로 소개한다고 합니다.

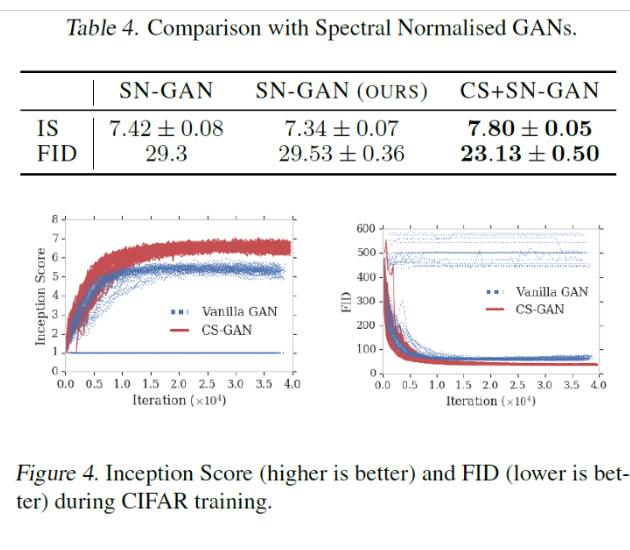

실험에 따르면 discriminator-guided latent optimization을 사용하는 GAN 모델은보다 안정적인 교육 역학과 더 나은 결과를 산출했습니다.

encoder 와 decoder 쌍으로 훈련되는 모델보다는

CS는 encoding과 decoding을 개개인의 측정과 복원 절차 그리고 온라인 최적화를 통한 저차원 측정으로 복원 신호를 분리해서 한다고 합니다.

먼말일까요?,,,,,,,,,,,,

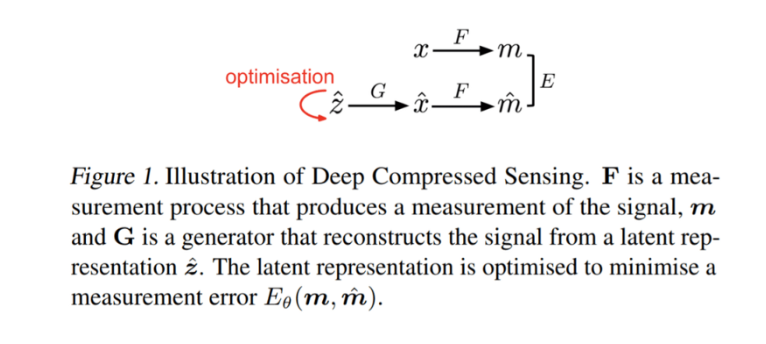

먼가 저것을 직접적으로 연결해서 하는 것이 아니라 m이라는 것이 생겼네요.

F는 어떤 측정 과정인데, latent representation을 최적화해서 2개의 Latent를 유사하게하면,

먼가 잘된다? 이런 느낌인가.............

“optimizing latent variables exhibits no mode collapse, one of the common failure modes of GAN training.”

이 방법을 사용했을 때 mode collapse가 안보인다고 하네요.