https://data-newbie.tistory.com/156

What is wrong with scene text recognition model comparisons? dataset and model analysis (네이버 논문) - 1

https://arxiv.org/abs/1904.01906 https://github.com/clovaai/deep-text-recognition-benchmark?fbclid=IwAR1JQZMgF39xFWbiZUNFmvbgyPX1x6hKkFmqSSbG4szytZUFqYuKa7m3nNc 갓 네이버에서 OCR 관련 논문을 내주셨..

data-newbie.tistory.com

앞 장에서 STR에 대해서 살펴보고 이제는, 대망의 실험!!

4. Experiment and Analysis

|

MJSynth SynthText |

AdaDelta ( decay rate - 0.95) 모든 파라미터 초기화 He씀

|

IC03 데이터 사용 안 함 |

Evaluation metrics

STR combinations in terms of accuracy, time, and memory aspects altogether.

이미지당 예측률도 보고 어떠한 데이터는 숫자랑 알파벳만 봤다고 한다.

스피드 부분에선 이미지당 인식하는 동안의 평균 시간을 봤다고 한다.

메모리 측면에선 전체 STR Pipeline 훈련해야 하는 파라미터 수를 봤다고 한다.

4.2 Analysis on training datasets

This result showed that the diversity of training data can be more important than the number of training examples, and that the effects of using different training datasets is more complex than simply concluding more is better.

위에서 머라 머라 했지만, 결국 발견한 것은 train 수 보다 얼마나 다양한 이미지가 있는지가 중요하다고 한다!

4.3. Analysis of trade-offs for module combinations

. On the other hand, for accuracy-memory trade-off, we observe that the feature extractor contributes towards memory most significantly. It is important to recognize that the most significant modules for each criteria differ, therefore, practitioners under different applications scenarios and constraints should look into different module combinations for the best trade-offs depending on their needs.

결국 각각의 Tradeoff (speed, memory, 예측률)에서 고려할 부분에 따라서 다른 모듈을 사용해야 하는 것 같습니다.

그래서 결국 잘 판단해서 하라고 하네요.

4.4. Module analysis

위에서 보여주는 기능들이 이전에는 못했던 것들에 대해서 해결해주는 부분이라는 것 같습니다.

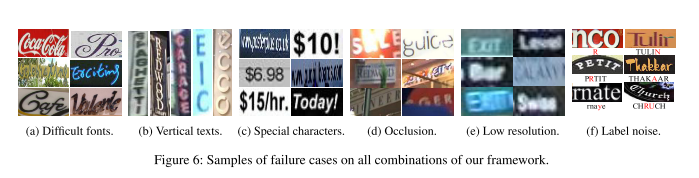

실패한 것들

1. Calligraphic fonts

이런 붓글씨는 표현이 하도 많아서 어려운데, 이런 다양한 문자의 표현은 일반성을 보장하면서 참신한 feature 추출기가 필요하다고 하네요. 또 다른 방법으로는 정규화가 있다고 합니다.

모델은 보통 training dataset에 overfitting 되기 때문에 이 부분을 좀 약하게 하면 , 인식하지 않을 수 있을까 하네요.

2. Vertical texts

대부분 STR 모델들은 수평 글자만 합니다. 그래서 수직은 다루지 못하는데요.

아직 이 부분에 대해서는 연구가 많이 필요하다고 하네요.

3. Special Characters

(c)를 보면 정말 특이한 표현들이 많은데요. 기존에는 이런 것들을 싹 제외했다고 합니다.

이러한 것들은 잘 못 예측하게 하고 모델의 방향성을 잃게 만들 수도 있다고 하네요.

그래서 네이버님들은 특수문자를 학습시키는 것을 제안하고 성능 향상을 결과로 냈다고 합니다.

4. Heavy occlusions

현재 방법은 폐색을 극복하기 위해 문맥 정보를 광범위하게 이용하지 않는다고 하네요.

저렇게 흐른 것도 다른 연구자가 고려해서 만들어 달라고 하는 거 보니 어려운 부분이 확실한 것 같습니다.

5. Low Resolution

저해상도면 잘 안된다고 하는데요, 그래서 최근에 SRGAN을 사용해서 해보려고 했는데, 오히려 더 글자 자체는 희미해지는 것 같더라고요. 다른 방법으로 느 Image pyrimids 고 해성도 모듈을 쓰라고 하네요.

6. Label noise

실패한 것을 보니 label에 noise가 있었다고 하네요.

이러한 noise가 현재 dataset에 어느 정도 있다고 하고 갓 네이버님께서 깨끗하게 정제해서 open source로 하겠다고 합니다.!!!!!!!!!!!!!!!!!!!!!!!!!!!

네이버 분들이 실패한 것들에 대해서는 항상 유념해야겠네요!

5. 결론

이전 모델들이 데이터셋도 불일치해서 엄밀한 검정이 안돼서, 틀을 만들어준 논문인 것 같습니다.

그래서 많은 사람들이 앞으로는 이것을 이용해서 Benchmark를 올리지 않을까 싶네요.

암튼 네이버님께 감사드립니다.

끝